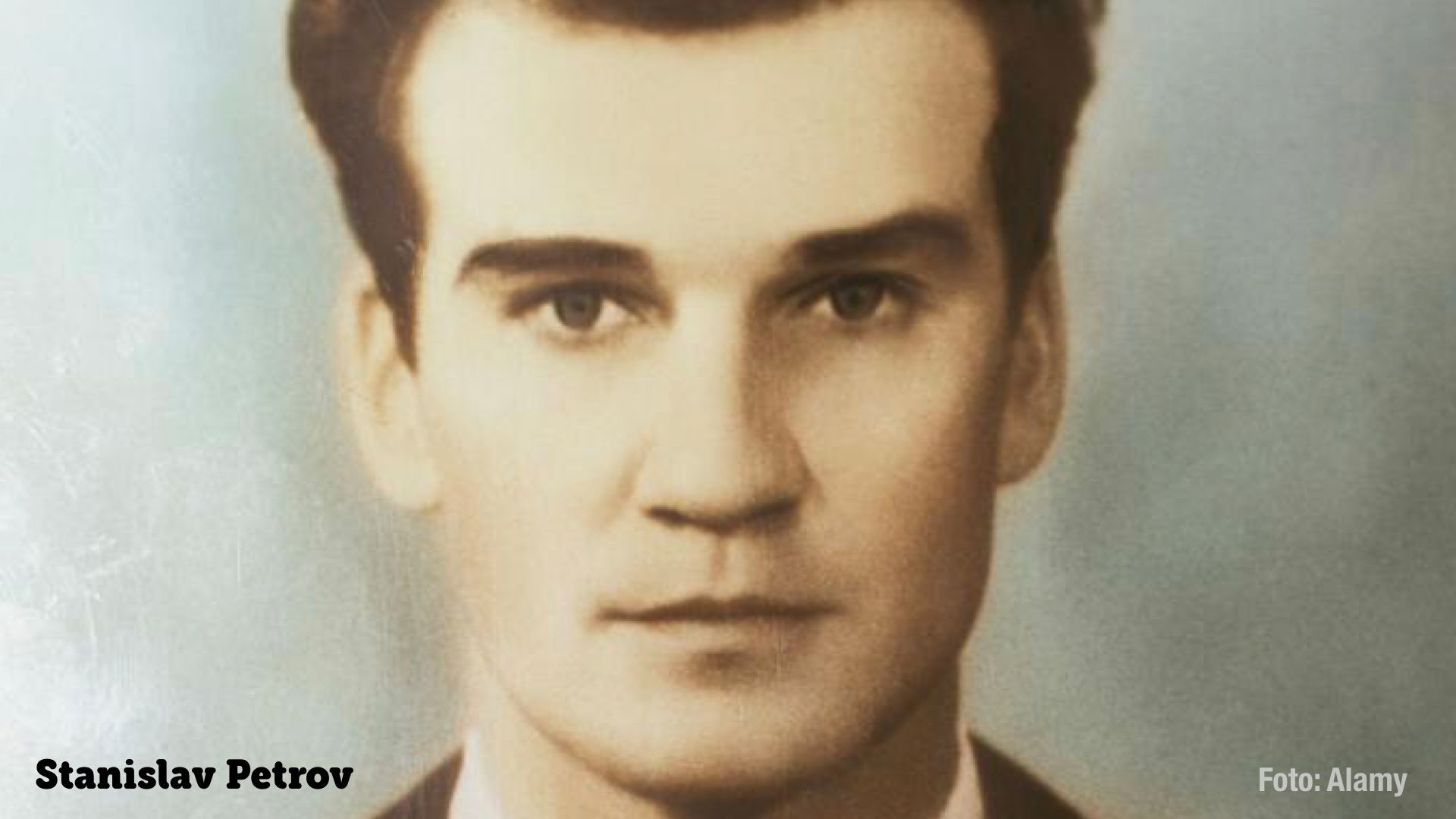

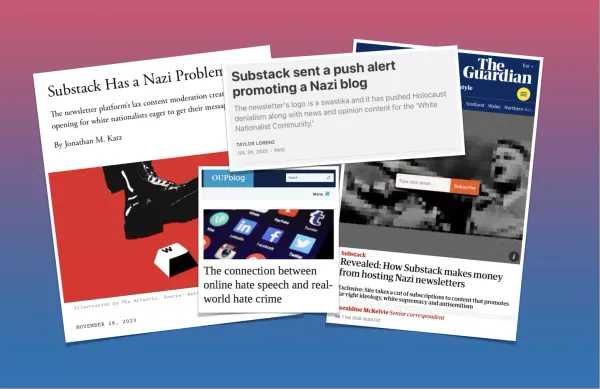

Det var den 26 september 1983. Jag var nio år gammal. Stanislav Petrov var 44 år. Ungefär som jag är idag. Han var inne på sitt andra raka arbetspass i kontrollrummet för det sovjetiska varningssystemet Oko. Plötsligt kom det som var kalla krigets värsta farhåga, larmet om en kärnvapenattack från USA. Systemet meddelade att fem missiler var på väg mot Sovjet.

Petrovs jobb gick nu ut på att föra vidare informationen så att Sovjetunionen kunde påbörja en motattack. Men Petrov gjorde aldrig det. Han bestämde sig för att rapportera falsklarm, i stället för att låta före detta KGB-chefen Yuri Andropov avgöra världens öde. I intervjuer har Petrov påpekat att han tyckte det var osannolikt att det var en kärnvapenattack med bara fem missiler. Det borde varit fler. År 2013 påpekade han att hans civila utbildning var avgörande. Att hans militära kollegor garanterat skulle ha rapporterat en attack.

Många experter har fört fram sannolikheten att en stor del av världens befolkning har Petrov att tacka för sina liv. Det avgörande i hans handling var förstås att han som människa vågade ifrågasätta datorsystemet. Ett datorsystem som hade feltolkat ett ovanligt väderfenomen.

Läslust

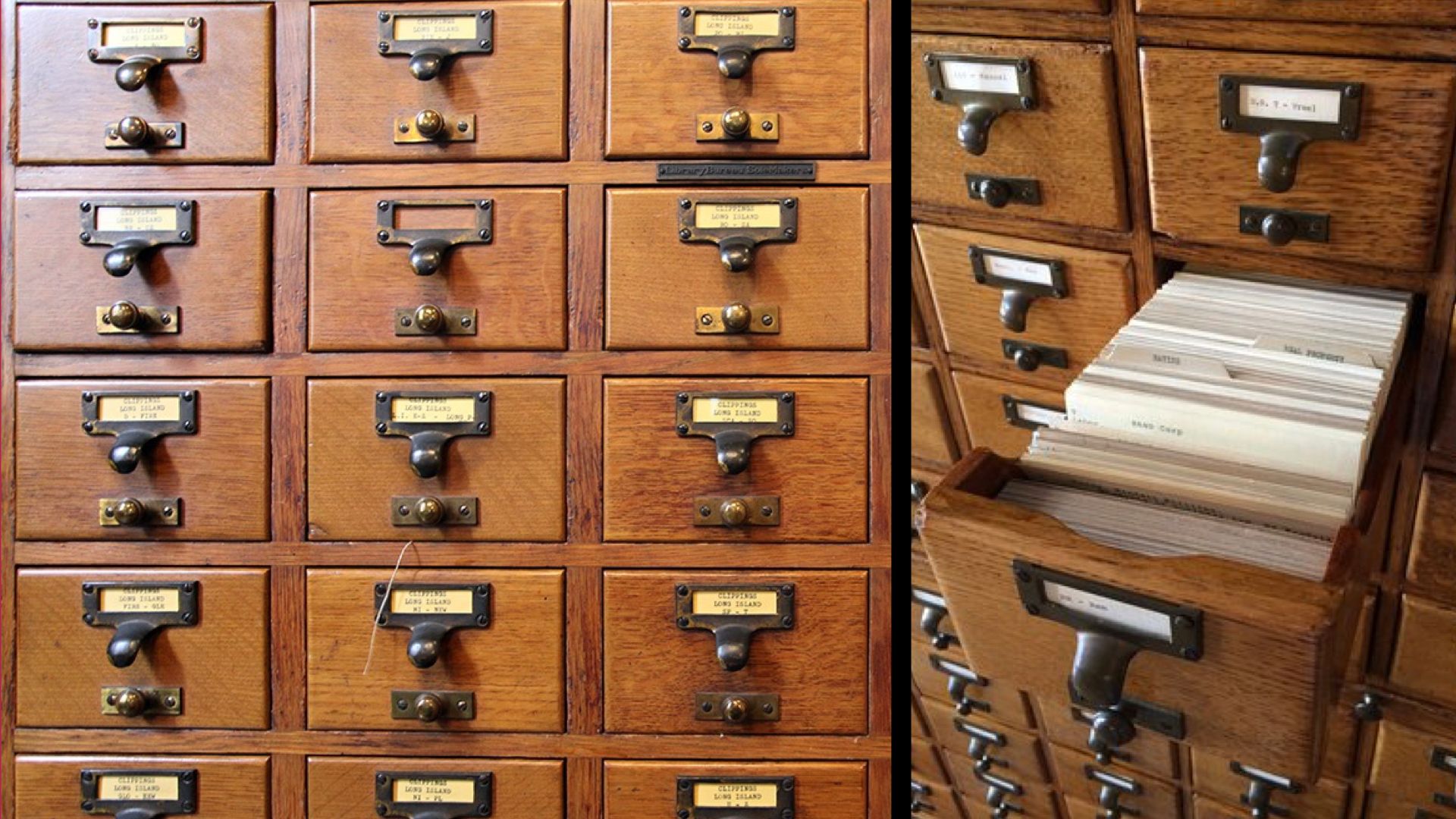

När det här utspelade sig var jag nio år och gick på en amerikansk skola i Saudiarabien. Jag älskade böcker. Därför älskade jag också att få lära mig om Dewey Decimal System, det klassificeringssystem som är vanligast på bibliotek runtom i världen för att kategorisera böcker i ämnesområden. I stora byråer med små lådor fanns små kort med kategorier som hjälpte mig att hitta nya, spännande böcker. Kategorierna sträcker sig från siffrorna 1 till 1000 och innehåller ofta decimaler för att täcka in specialområden. Därav “decimal system”.

Det här innebär också att alla världens ämnesområden delas in i tio huvudgrupper. Allt ifrån datavetenskap till geografi och historia.

Ämnet religion har siffrorna 200-299. Aningen obalanserat är det att kristendomen tilldelats huvudkategorierna 200-289 medan resten av världens religioner får samsas i de resterande 10.

När jag var nio år så låg ämnesområdet homosexualitet i kategorin 301.424, studier av kön i samhället. År 1989 placerades det även i 363.49, sociala problem. Men många böcker behåller förstås också sina tidigare kategorier från 1932 då homosexualitet placerades i 132, mentala störningar, och 159.9, abnorm psykologi.

Föränderliga värderingar

Böcker som hanterade homosexualitet var minst sagt kontroversiella år 1932. I Nazityskland började man 1933 bränna böcker som på något sätt innehöll texter om homosexualitet. Homosexuella inom den hemliga statspolisen Gestapo mördades, och mellan 1933 och 1945 fängslades homosexuella runtom i landet. Av de som sedan också hamnade i koncentrationsläger räknar forskare med att cirka 60% avrättades. Många blev offer för medicinska experiment där man sökte botemedel för homosexualiteten.

Något som under många år gäckade historiker var hur effektivt Tyskland kunde kartlägga, hitta, terrorisera och avrätta homosexuella, och förstås judar, romer och de människor som helt enkelt kategoriserades som anti-sociala.

Idag vet vi att svaret på den frågan är automatisering.

Mannen till vänster i bild är Adolf Hitler, mannen som kom till makten i samband med bokbränningen. Mannen som sitter till vänster om Hitler är Thomas Watson, som ledde företaget IBM under åren 1914 till 1956.

Automatisering av terror

Att transportera mer än sex miljoner människor först från sina hem till ghetton och sedan från ghetton till koncentrationsläger och gaskammare var obeskrivligt fasansfullt, och uppseendeväckande att rent logistiskt genomföra.

Med start redan 1933 så användes IBMs exklusiva hålkortsteknik, samt dess monopol på informationsteknik, för att kategorisera och effektivisera Hitlers plan som fick namnet Den slutgiltiga lösningen av judefrågan. Efter släppta dokument under 2012 vet vi att hålkorten, maskiner, utbildning och service styrdes från IBMs huvudkontor i New York och senare genom dotterbolag i Tyskland.

Det här är en bild på en av de många maskiner som var byggd och utplacerad för ändamålet. De användes för att hantera matransonering för att svälta fångarna, och för att tågen skulle gå i tid, men också för kategorisering av människor.

År 2012 släpptes dokument som avslöjade hur några av koderna för koncentrationsläger och människor såg ut. Det var siffra 3 för homosexuell, 8 för jude, 9 för anti-social, och siffra 12 för zigenare. Det fanns även koder för att kategorisera hur människor dog. Specialbehandling var omskrivningen för gaskammare.

Thomas Watson är i mångas ögon en beundransvärd affärsman som bidrog till att bygga upp IBM till ett oerhört lönsamt världsomspännande företag. Han var en av tidens rikaste män och kallades världens bästa säljare. Många lyssnar till hans råd. I ljuset av vad hans företag åstadkommit är det dock många av hans uttalanden som känns avskyvärda:

“Att göra affärer är ett spel, det bästa spelet i världen om du vet hur du spelar.”

Det är också talande att när detaljer om IBMs roll under förintelsen läckt ut har företagets försvar, även i modern tid, byggt väldigt mycket på premissen:

“Vi är bara ett teknikföretag.”

Klassificering av människor

Kategorisering, etikettering och betygsättning av människor och information är ett verktyg vi naturligt använder för att hantera den omöjliga komplexiteten i de miljöer och sammanhang vi som människor försöker förstå. Det är oerhört effektivt, men bidrar också till några av de djupaste problem vi står inför.

Så sent som 2016 utfördes studier för att visa på hur kriminella kan identifieras enbart med hjälp av ansiktsproportioner. Det här är en form av frenologi – att avgöra beteendet baserat på huvudform – som många säkert antagit att forskningsvärlden övergett. Men bara i söndags, den 24:e november 2019, fick vi veta att Kina driver arresteringar baserat på algoritmer, efter den så kallade China Cables-läckan. I juni 2017 flaggades mer än 24 000 namn som ”misstänka” och på en vecka hittade Xinjiangs säkerhetspersonal 15 683 av dessa människor och placerade dem i interneringsläger.

Från ett försök med ansiktsigenkänning i England, där man vill hitta kända kriminella, nåddes vi i maj i år av rapporter kring hur system för ansiktsigenkänning har fel i 96 % av fallen. Och förstås oftast när det gäller människor som inte är vita. I artikeln hos Independent handlar det om en 14-årig skolpojke som fick lämna fingeravtryck efter en sådan felidentifiering.

Men vi behöver heller inte gå så långt som automatisering och AI för att hitta exempel på hur människor far illa. När vi nu systematiserar människor i databaser och till exempel skolsystem så dyker det upp frågeställningar av den här arten:

“Min elev, som är trans, visas med sitt riktiga namn i skolplattformen. Hur gör jag för att detta inte ska röjas för hans klasskompisar?”

En skolplattform tillåter förstås inte varken elev eller lärare att ändra namn. Många system, ofta även offentliga, klarar inte av att på den mest basala nivån skydda människors integritet.

Det är fortfarande olagligt att vara homosexuell i 70 länder. Ofta leder till fängelse i flera år. I en handfull är det förenat med dödsstraff.

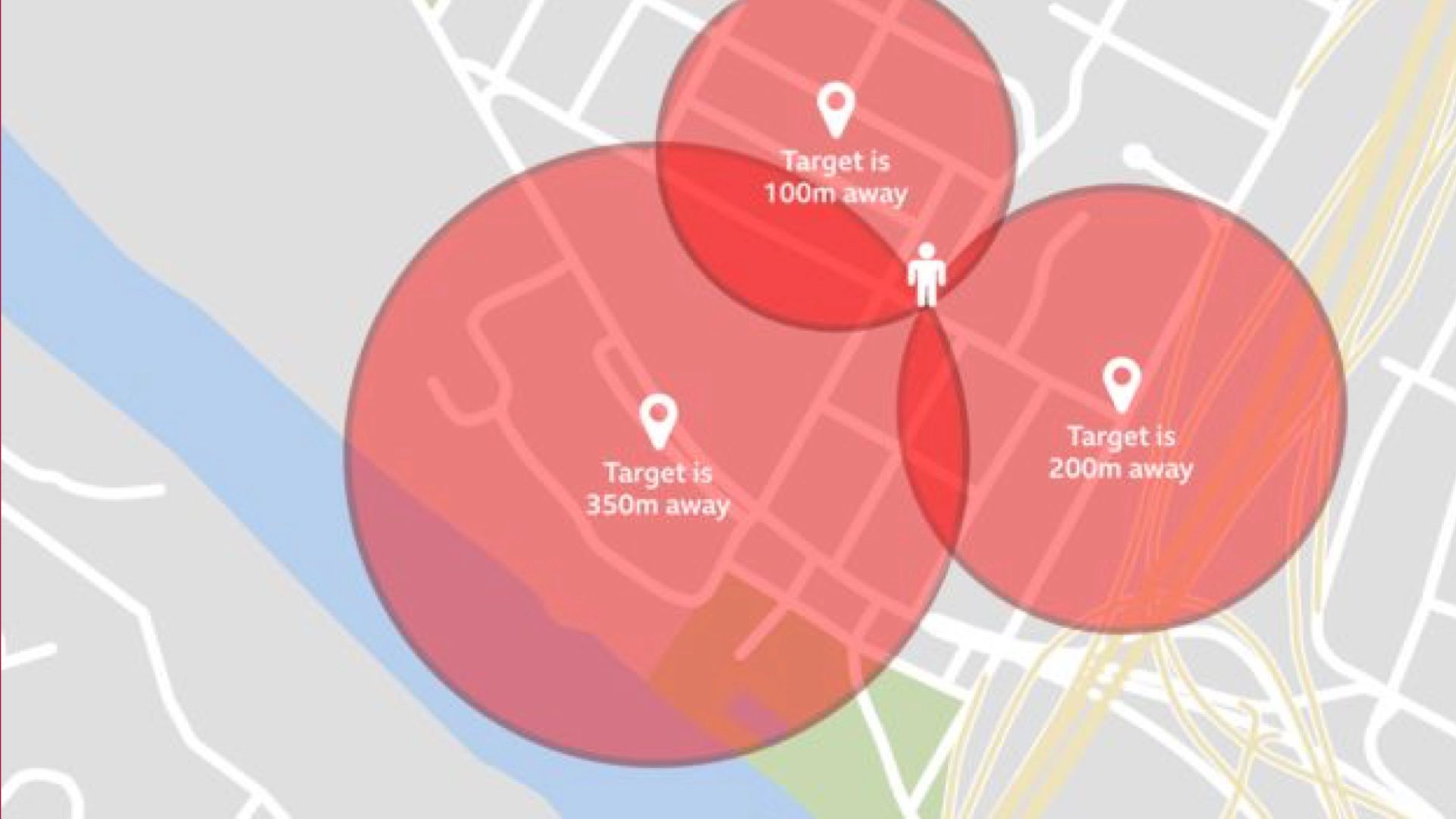

Därför blir det otäckt när dejtingappar visar avstånd till andra användare som är online. Något som många säkert glömmer bort när de reser. Men de visar ju bara avstånd, tänker många. De visar inte riktning.

I slutändan behövs dock bara en manuell triangulering för att hitta en nästan exakt position med denna funktion. Ställ dig på tre olika platser och gör en cirkel som har detta angivna avstånd som radie. Där dessa tre cirklar möts är platsen som individen står på.

Den här trianguleringen kan göras av en person som ställer sig på tre olika ställen, eller förstås ännu snabbare av tre personer med järnrör som arbetar tillsammans.

Apparna som ska förbättra utsätter sin egen målgrupp för fara. Och människorna i riskzonen har ofta inte blivit informerade om riskerna på ett tillfredställande sätt. Bland annat har rapporter kommit om att polis i Egypten använt dejtingappar för att spana på och komma åt homosexuella.

Uppdatering: I och med denna fara har en del dejting-appar börjat med olika former av rese-varningar.

Processerna tar inte ställning

När vi hör talas om teknik där människor far illa så har de ofta en sak gemensamt. Det är de röstsvaga och diskriminerade – alltså människor som redan tjänas dåligt av samhället – som är mest utsatta. Människor som redan gynnas av samhället har ofta en god relation till teknik och kan se och uppskatta hur den underlättar deras vardag.

Vad som blivit tydligt när jag arbetar med mina efterforskningar kring etik och design, och varför människor far illa om och om igen, så dyker hela tiden metoder och processer upp som en bidragande faktor. Det finns inget i våra processer som på ett systematiskt sätt tar hänsyn till negativ mänsklig påverkan.

De senaste åren har begrepp som agil och lean blivit vardagsmat för organisationer och företag. Överallt jobbar vi med Inkrementella och iterativa utvecklingsmetoder. Metoderna bidrar till att skapa värde genom täta avstämningar med de som köper produkter och tjänster, så att de med större sannolikhet får något de blir nöjda med.

I en ofta använd illustration av en agil process, skapad av svensken Henrik Kniberg, byggs först en skateboard. Denna visas och testas för att i nästa iteration bli en sparkcykel. Den cirkulära återkopplingen bidrar sedan till att produkten utvecklas till en cykel, en motorcykel och en bil. Men poängen är att du inte i förväg visste att det skulle bli en bil.

Rätt sätt är inte alltid rätt sak

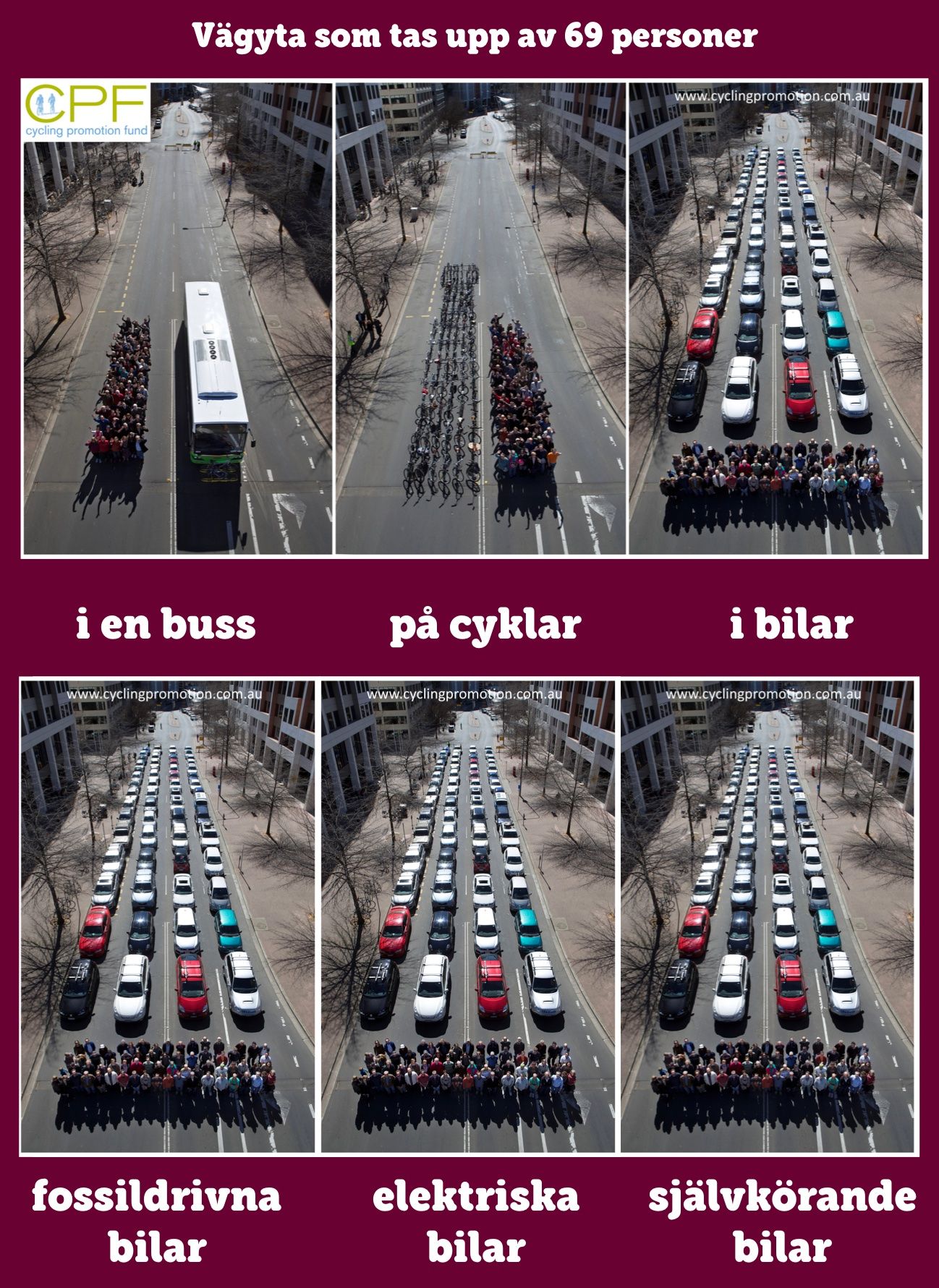

Jag tror absolut på förmågan i agila metoder att på ett mer resurseffektivt sätt jobba sig framåt för att lösa problem hos målgruppen. Men det förhindrar inte lösningarna från att också bidra till trafikstockningar, olyckor, föroreningar, avgaser eller att på andra sätt utsätta människor för fara.

För även om vi hela tiden blir bättre på att bygga på *rätt sätt*, och kan nå fler och påverka fler, så har vi ännu inte anammat metoderna som hjälper oss att bygga *rätt sak* – att aktivt arbeta för det som minimerar negativ påverkan.

Som exempel brukar jag visa denna kända bild från Australien som illustrerar hur mycket vägyta som tas upp av 69 trafikanter i en buss, på cyklar och till slut: i bilar. Bilarna, trots att det alltså inte är en bil per person, tar i särklass mest yta. De mest innovativa företagen bejublas när de svarar med att lansera elbilar och autonoma bilar. Som givetvis tar exakt samma mängd vägyta som fossildrivna bilar. Det är ofta pengarna som styr innovations-riktningen, och påverkan på välbefinnande mäts inte som framgångsfaktor.

För att understryka min poäng om vem som far illa, och när vi ändå snuddar vid ämnet sparkcyklar, så tog jag i onsdags dessa två bilder på stan. Medan det kan tyckas att en av dessa sparkcyklar utgör ett större hinder än den andra så är det ofta en tolkning grundad i ett privilegium.

Sanningen är förstås att bägge sparkcyklar utgör ett enormt hinder för den som är synskadad, eller som sitter i rullstol, och måste hitta ett säkert sätt att navigera runt sparkcykeln för att ta sig vidare längs trottoaren.

När man rör sig på stan med den här insikten så blir det skrämmande uppenbart hur elsparkcyklar påverkar framkomligheten särskilt mycket för vissa människor. Nästan oavsett hur de står, begränsar de i mycket stor grad rörelsefriheten för människor som har såväl temporära som permanenta funktionsnedsättningar.

Osynliga människor

Det farligaste med fientlig design är när den börjar bli osynlig för majoriteten av människor. Fientlig design är alltså när någon bygger produkter och tjänster som aktivt exkluderar och försämrar för vissa människor.

Fientlig arkitektur (exkluderande design) är till exempel något som många kan upptäcka i sin vardag. Det är när vi ser hur man sätter spikar på kanter som skulle kunna sittas på, eller mer subtilt, armstöd i mitten av bänkar så att de inte går att ligga på. Men i förlängningen blir även denna design helt osynlig.

I detta exempel har man installerat en solladdare för mobila enheter på en parkbänk. Man har säkerställt att solladdaren sitter i mitten av bänken och sticker upp en bra bit. Återigen så blir det design av en bänk som man inte kan vila liggande på om man är människa som har det behovet.

Vissa människor blir alltså helt exkluderade, på ett osynligt sätt, och därmed raderade från vårt medvetna. De har redan själva en alltför svag röst för att protestera. Och eftersom det inte alls är uppenbart – och majoriteten faktiskt gynnas – finns nu allt färre kvar som kan protestera å deras vägnar.

I vår vardag utspelar sig det här med människor som inte blir bjudna på fester därför att de inte har konton i rätt sociala medier, människor som inte längre vet hur man söker jobb, människor som inte kan betala parkering eller föräldrar som har svårt att se all information om sina barn i krångliga skolplattformar.

För många människor blir hela samhället som att besöka någon annans hem och försöka förstå hur tv:n och spisen funkar…

I bästa fall har de en släkting som kan hjälpa dem.

Design diskriminerar

Till min personliga besvikelse upptäckte jag för ett par år sedan hur även den designmetodik jag jobbat med i många år i grund och botten är diskriminerande.

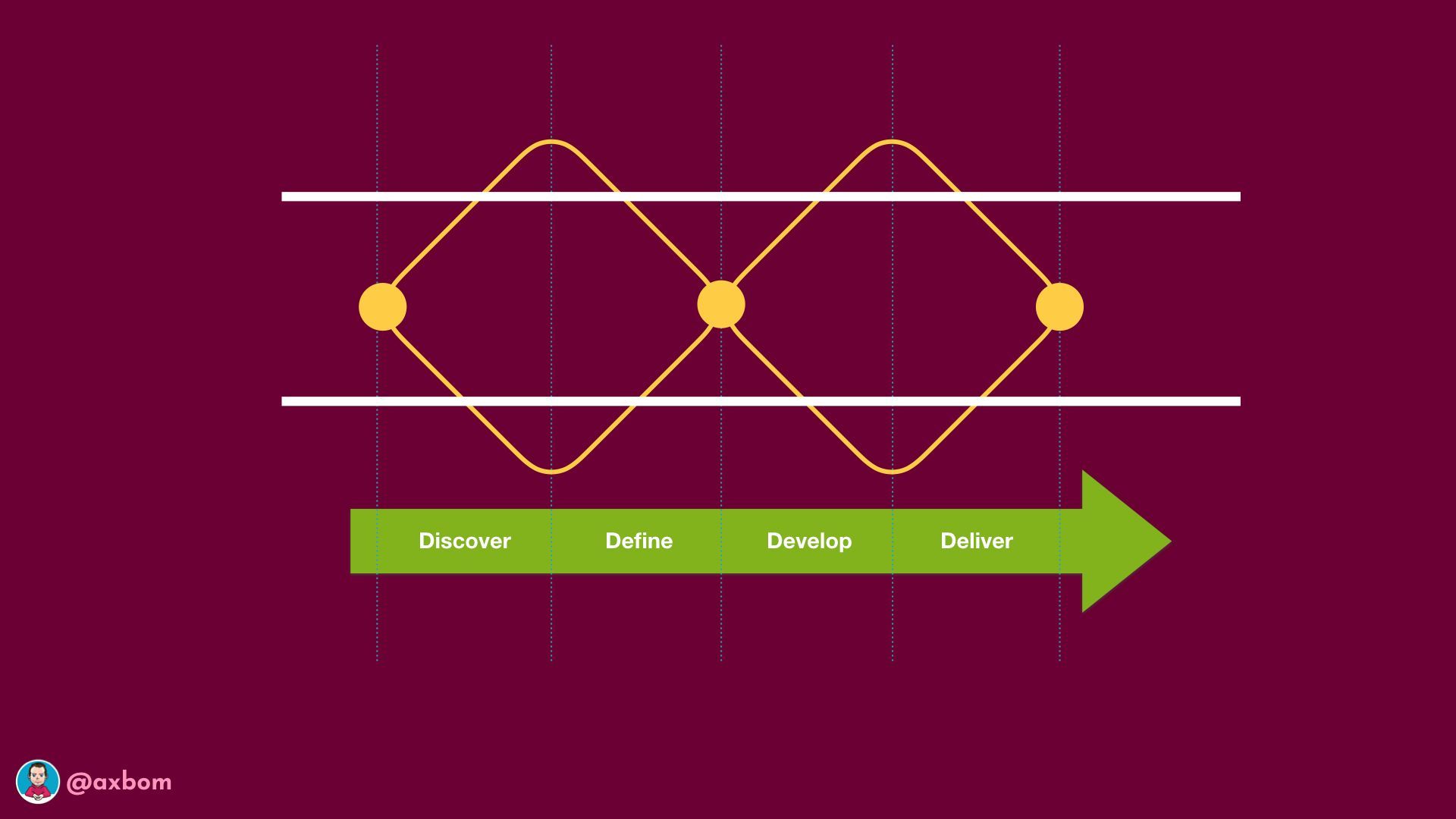

I det som populärt i designsammanhang kallas för “double diamond” ser vi hur man inom design anstränger sig för att förstå problembilden och behov så brett som möjligt. Men allt eftersom tiden går så måste vi bestämma oss för vilka behov vi tar hänsyn till.

Och då väljer vi naturligt att fokusera på de behov som flest människor har. Det som många har gemensamt.

Resultatet blir att människor i utkanterna av efterforskningnarna, och i utkanten av vad som kan beskrivas som generella behov, helt enkelt inte får någon hänsyn i design-lösningen. Det finns till och med ett begrepp i branschen för detta: “edge-cases”. Om du är ett edge-case är du inte en människa vars behov vi på något sätt prioriterar.

Om vi byggde med människors välbefinnande i fokus från början skulle tillgänglighet för människor med funktionsnedsättning *aldrig* vara något som kom i andra hand, som något separat. Ett edge-case skulle bedömas utifrån den skada vi åsamkar en människa, inte utifrån hur ovanlig händelsen är.

I stället prioriteras idag behoven hos de som redan gynnas av samhället – som passar in och är normaliserade – och gynnas dubbelt eftersom just deras behov hamnar i blickfånget.

Mätning ökar synligheten

För att kunna jobba etiskt, i meningen att vi undviker att bygga sådant som gör att människor far illa, måste mänskligt välmående vara en del i beslutsfattandet. Vi måste våga dokumentera, mäta och spekulera i hur människor kan fara illa.

Den här informationen kan sedan användas för att

- motivera beslutsfattande

- synliggöra människor som annars inte hörs

- prioritera vägval i teknisk utveckling

- förstå när man ska backa ett beslut för att man ser konsekvenserna

- skapa en spårbarhet (dokumentation) för etiska vägval och hänsyn

(se Tim Berners-Lee och ContractForTheWeb.org)

Vi kommer aldrig kunna förutse allt, men när våra metoder inte ens uppmuntrar till att prata om det så är negativ påverkan nästan garanterad. Vi kan alltid bli bättre på att förstå vem som drabbas hårdast och vilken påverkan vi själva vill bidra till.

Här är två metoder:

Påverkanskartläggning

En påverkanskartläggning är en form av riskanalys som tar hänsyn till vem som påverkas och vad som händer. Varje påverkan utgår från en beskrivning av vem som drabbas och vad som händer dem, och denna påverkan skattas sedan enligt fyra faktorer:

- Hur omfattande är denna påverkan?

Handlar det om pinsamheter eller om liv och död? - Hur mycket bidrar vi?

Alltså, om vi inte skulle ha gjort något, skulle denna påverkan finnas? Ju mer vi bidrar, desto mer är det vårt ansvar att minimera negativ påverkan. - Hur försummade är de som drabbas?

Om de som drabbas redan har en svag röst i samhället är det än viktigare att hjälpa dem att stärka den rösten. - Hur sannolikt är det att det händer?

Ju högre sannolikhet, i kombination med övriga faktorer, desto viktigare att åtgärda.

Varje svar är en gemensam bedömning och faktorerna skattas och uppdateras regelbundet allt eftersom man lär sig mer, och allra helst eftersträvar man förstås att involvera människor med förstahandsupplevelser.

Påverkanskartläggning kan vara ett kraftfullt verktyg eftersom det kan användas för såväl positiv som negativ påverkan. Dess styrka som verktyg är att det kan hjälpa ett team inom produktutveckling att prioritera inte bara utifrån ekonomiskt utfall och konvertering, utan även utifrån vem som fara illa.

Använd metoden för att hjälpa din organisation förstå påverkan, och prioritera aktiviteter.

Den inkluderande pandan

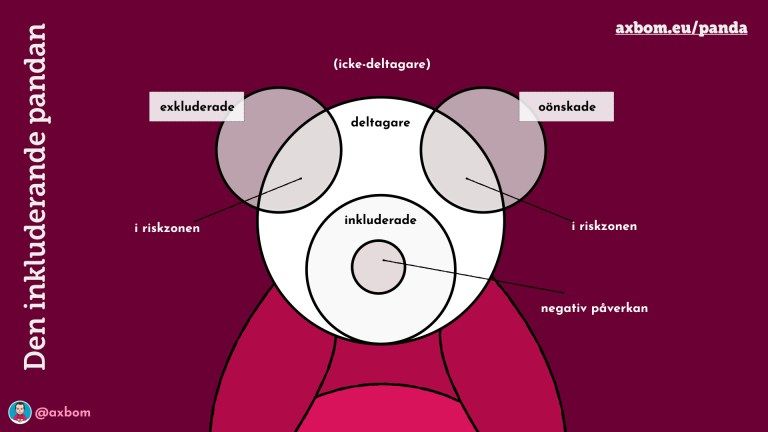

Pandan är en ingång för en organisation att lättare förstå alla de människor som kan påverkas av en digital lösning.

Cirkeln i mitten, eller mulen, inbegriper alla de som vi har i åtanke som vår målgrupp, de vi avsiktligt bygger för.

Örat till vänster representerar de exkluderade. Det kan vara människor som kan ha nytta av lösningen men ingen energi läggs på att bygga så att de lått får åtkomst till den. Det kan också vara människor som inte alls gynnas av lösningen utan direkt missgynnas av den, som i fallet med elsparkcyklarna.

Örat till höger representerar de oönskade. Vi vill inte att dessa personer ska använda lösningen, antingen för att de kan fara illa själva eller för att de kan skada andra. Enklaste exemplet är att vissa lösningar för vuxna bör utesluta barn. Och vissa lösningar för barn bör utesluta vuxna.

Det faktum att öronen överlappar med huvudet pekar på att det sannolikt finns människor i grupperna exkluderade och oönskade som lyckas använda lösningen i alla fall.

Vilket gör att vi kan avsluta med nosen, som är den del av personerna du aktivt bygger för som far illa ändå. Antingen för att du dragit fel slutsatser om deras behov, eller för att de drabbas av beteendet hos oönskade människor.

När du regelbundet kartlägger deltagare och icke-deltagare med hjälp av den inkluderande pandan så får du hjälp att börja förstå effekter på andra människor än målgruppen. Du får också hjälp att förstå att din lösning alltid är större än de människor du tror att du riktar dig till.

Handla som människa

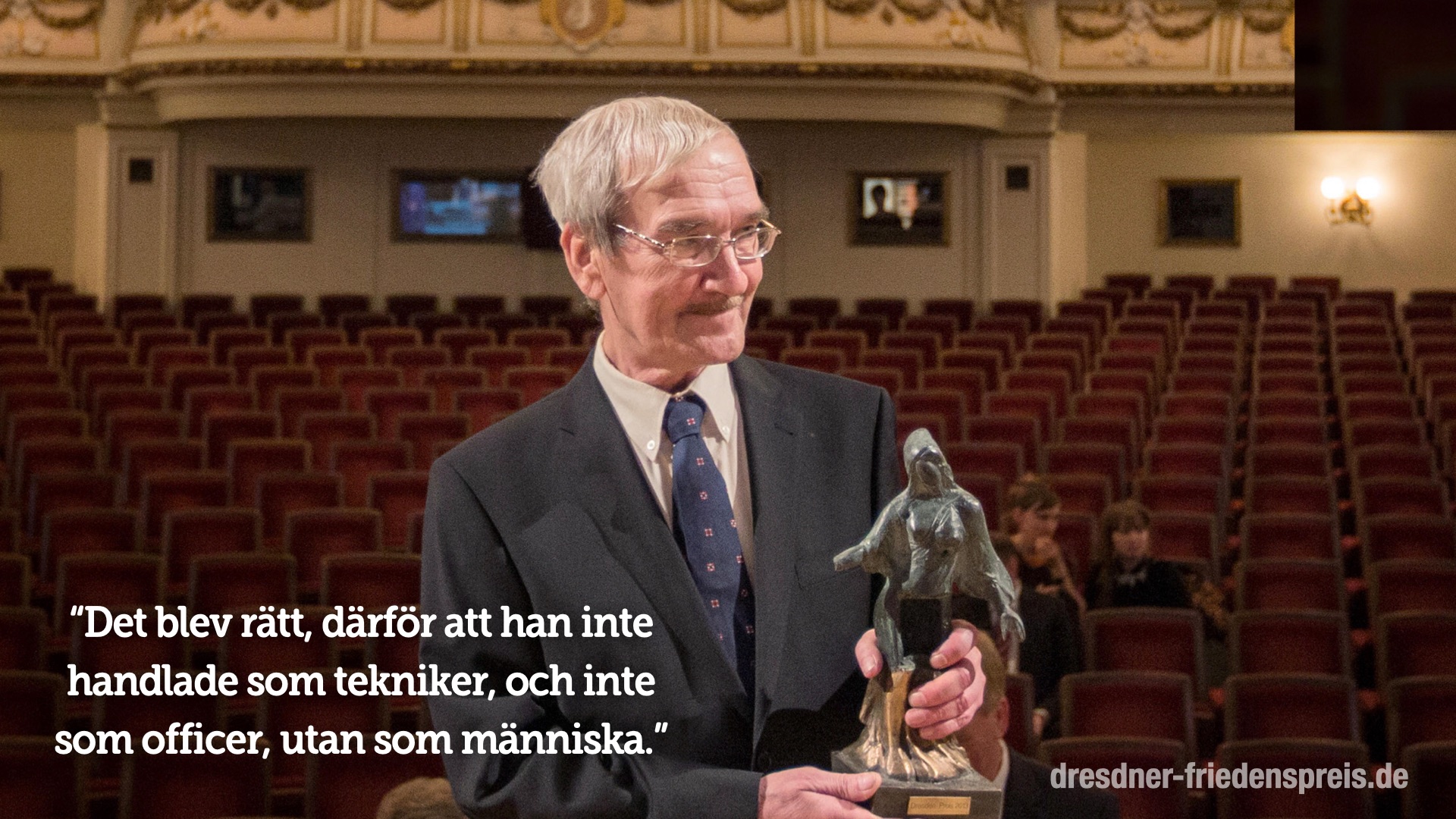

När Stanislav Petrov tog emot det internationella fredspriset Dresdenpriset år 2013 för sitt agerande i att förhindra ett tredje världskrig ingick följande formulering i motiveringen:

”Det blev rätt, därför att han inte handlade som tekniker, och inte som officer, utan som människa.“

Stanislav Petrov gick bort omärkbart i maj 2017, men den som vill fortsätta handla som människa kan göra det, genom att:

- Våga ifrågasätta när teknik agerar beslutsfattare

- Våga ifrågasätta den historiska data, och klassificering, som våra informationssystem och bibliotek håller vid liv

- Förstå att allt som kan byggas inte ska byggas, hur lönsamt det än är

- Undvika att klassificera människor, men prata gärna om förmågor och försummelse

- Synliggöra när människor far illa

- Stå upp för att mänskligt välmående ska vara en central del i all teknisk utveckling, och något som mäts jämte lönsamhet

Därför vill jag också avsluta med ett hoppfullt citat från en ung flicka som skrev följande i sin dagbok när hon var 14 år, som en stark påminnelse till oss alla.

”Så underbart det är att ingen behöver vänta ett enda ögonblick innan de börjar förbättra världen!”

— Anne Frank

Den här artikeln finns också på engelska.

Läs mer

- Stanislav Petrov – Wikipedia

- ‘How I stopped nuclear war’ (BBC)

- Stanislav Petrov saved more lives than just about any human who ever lived – Vox

- Stanislav Petrov, ‘The Man Who Saved The World,’ Dies At 77

- Dewey Decimal Classification – Wikipedia

- IBM & “Death’s Calculator”

- IBM’s Role in the Holocaust – What the new documents reveal

- IBM And Nazi Germany – CBS News

- Neural Network Learns to Identify Criminals by Their Faces – MIT Technology Review

- Exposed: China’s Operating Manuals For Mass Internment And Arrest By Algorithm

- Facial recognition wrongly identifies public as potential criminals 96% of time, figures reveal | The Independent

- Sanktionsavgift för ansiktsigenkänning i skola – Datainspektionen

- Gay dating apps still leaking location data – BBC News

- Dating apps are refuges for Egypt’s LGBTQ community, but they can also be a trap – The Verge

- The Canberra Transport Photo

- Mackan Andersson on Twitter: korkat placerade elsparkcyklar

- Exkluderande design – Wikipedia

- Homepage – Contract for the Web

- Introducing the Inclusive Panda • axbom.blog

- AI ethics is all about power

Tack

Stort varmt tack till Sarah Larsson Bernhardt och Deeped Niclas Strandh, tillsammans Social by default, som bjöd in mig att presentera på Internetdagarna 2019 i spåret Digital etik och moral. Jag skräddarsydde den här föreläsningen för tillfället och det är utan tvivel den mest emotionellt starka föreläsningen jag komponerat och presenterat.

Presentationsmaterial

Samtliga bilder från dagens presentation finns på Speakerdeck.

Medlemsdiskussion