Om och om igen är det de mest utsatta som drabbas av osynliga automatiserade beslut som få (om någon) har insyn i hur de fungerar. Och det blir oerhört svårt för en individ att få rätt mot de som trycker på knappen – de flesta människor vet ju inte varför de felbehandlas, eller ens att det händer. Och det vet nog inte handläggaren heller.

När det dessutom hänvisas till sekretess och systemen inte får granskas av journalister eller andra externa parter, ja vad lever vi i för samhälle då? Hur ska förtroendet för myndigheter och offentlig sektor bibehållas?

Systemet har använts av Försäkringskassan sedan åtminstone 2013.

SvD skriver:

"Systemet pekade gång på gång ut oskyldiga mammor och föräldrar med utländsk bakgrund, låg utbildning eller inkomst.

Kvinnor drabbades särskilt. De fick mycket oftare den högsta risknivån, samtidigt som hälften av dem var helt oskyldiga.

Och trots att kvinnor och män stod för ungefär samma andel fel i verkligheten så pekade systemet ut (konstaterat oskyldiga) kvinnor som sannolika fuskare mer än dubbelt så ofta som (konstaterat oskyldiga) män.

[…]

Vi ser också att systemet var sämre på att hitta män och rika personer som faktiskt gjort fel."

– Ur SvD:s granskning Hemlig AI såg oskyldiga kvinnor som vab-fuskare

Effektivitet viktigare än rättvisa

Om system är så kallat "effektiva" så tycks det spela mindre roll idag om de samtidigt är orättvisa. Effektivt på riktigt är det förstås mest för de redan gynnade - och för makthavaren, som slipper sätta sig in i varje ärende.

Det är, hör och häpna, faktiskt inte särskilt effektivt för de som gång på gång blir oskyldigt drabbade av system som förstärker fördomar och felbehandlingar.

Försäkringskassans undvikande

Något som förtjänar mer uppmärksamhet i hela berättelsen är också hur Försäkringskassan gör allt för att undvika journalisternas frågor, inklusive att envist hävda sekretess. För att testa ärligheten i detta frågar journalisterna till slut efter information som man vet finns helt öppet i årsrapporten. Svaret från Försäkringskassan blir förstås att det inte kan lämnas ut eftersom det är sekretessbelagt.

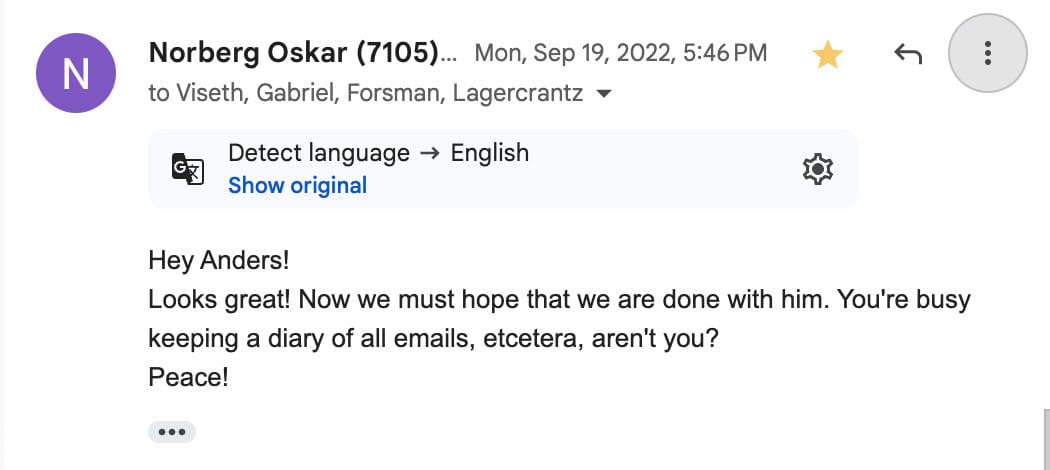

I ett annat händelseförlopp skickas ett gruppsvar till en konversation med journalisten från Lighthouse där man tydligt trodde att journalisten plockats bort från mejltråden. Ungefär "Nu får vi hoppas att vi slipper höra mer från honom" skriver de om Gabriel Geiger.

Jag undrar försiktigt hur vi skulle vilja poängsätta Försäkringskassans hantering.

Faran med osynligt beslutsfattande

Fler och fler människor blir behandlade som siffror, i många olika sammanhang. Genom att behandlas som siffror förmodas att en matematiskt korrekt och ofelbar hantering av människan ska kunna ske i alla lägen där datorer används för beslut. Det blir en frontalkrock mellan förväntningar på datorer och en förståelse för människans tillstånd.

I diagrammet och förklaringsmodellen Elementen inom AI-etik, från juni 2023, förklarar jag osynligt beslutsfattande så här:

"Ju mer komplexa algoritmerna blir, desto svårare är de att förstå. I takt med att fler är inblandade, tiden går, integrationer med andra system görs och dokumentationen är felaktig, desto mer undgår de mänsklig förståelse. Många företag kommer att dölja egen kod och undvika granskning, och ibland själva förlora hela bilden av hur koden fungerar. Man kommer inte kunna förklara hur eller varför vissa beslut tas. Att avkoda och förstå hur beslut fattas kommer därmed att vara öppet för oändligt färre personer.

Och det stannar inte där. Detta påverkar också människors autonomi. Genom att dölja beslutsprocesser (hur, när, varför beslut fattas, vilka alternativ som finns tillgängliga och vilka personuppgifter som delas) är det allt svårare för individer att göra väl underbyggda val för sitt eget bästa."

– Läs mer i Elementen inom Digital Etik och Elementen inom AI-etik.

Avslöjandet om Försäkringskassan är långt ifrån det första och långt ifrån det sista exemplet vi har sett och kommer få se. Frågan blir närmast när någon på riktigt kommer ställas till svars för diskrimineringen och alla människor som far illa.

I Nederländerna avslöjades för fyra år sedan att tusentals familjer felaktigt anklagats för bedrägeri avseende barnbidrag, krävts på stora pengabelopp och fått sina liv förstörda. I den stora skandalen så avgick den nederländska regeringen till slut, men återuppstod senare relativt opåverkade. Konsekvenserna rinner av makthavarna, om och om igen, och därmed finns få incitament för bättring.

Smällar och livskriser, som ibland även leder till dödsfall, drabbar istället de marginaliserade människor som inte ens får veta hur de behandlas av algoritmer.

Om och om igen.

_____

Per Axbom är utbildare, föreläsare och rådgivare inom digital etik, författare till handboken Digital omtanke och medgrundare av Tankesmedjan Dataskuggan.

Referenser

Mer läsning om algoritmer som drabbar utsatta och kullkastar liv och tillvaro.

- Amnesty International (2024). Sverige: Försäkringskassan måste upphöra med sitt diskriminerande system, amnesty.se, 27 november.

- Amnesty International (2024). Danmark: AI-verktyg riskerar att diskriminera människor som redan lever i utsatthet, amnesty.se, 13 november.

- Amnesty International (2024). France: Discriminatory algorithm used by the social security agency must be stopped, amnesty.org, 16 oktober.

- Amnesty International (2021). Dutch childcare benefit scandal an urgent wake-up call to ban racist algorithms, amnesty.org, 25 oktober.

- Axbom, Per (2023). Förklaringsmodell för ansvar, påverkan och makt inom AI. axbom.se, 11 december.

- Axbom, Per (2023). Elementen inom AI-etik. axbom.se, 19 juni.

- Axbom, Per (2022). Elementen inom digital etik. axbom.se, 4 april.

- de Heer, Sarah (2023). A Scandal on AI in Administration, Again: Fortifying Fundamental Rights in the Age of AI, verfassungsblog.de, 25 juli.

- Granberg, Sascha & Geiger, Gabriel (2024). Hemlig AI såg oskyldiga kvinnor som vab-fuskare, Svenska Dagbladet, 27 november.

- Granberg, Sascha & Geiger, Gabriel (2024). Sweden's Suspicion Machine, Lighthouse Reports, 27 november.

- Heikkiläa, Melissa (2022). Dutch scandal serves as a warning for Europe over risks of using algorithms, Politico, 29 mars.

- Kronblad, Charlotta (2022). Algoritmisk orättvisa – när domstolen är blind för digitala bevis, Advokaten nr 6 2022 Årgång 88.

- Meaker, Morgan (2024). Algorithms Policed Welfare Systems For Years. Now They're Under Fire for Bias, Wired, 16 oktober.

- Schaart, Eline (2021). Mark Rutte pulls plug on Dutch government, plans immediate return, Politico, 15 januari.

- Stacey, Kiran (2023). UK risks scandal over ‘bias’ in AI tools in use across public sector, The Guardian, 23 oktober.

- Yigitcanlar et al (2024). Local governments are using AI without clear rules or policies, and the public has no idea, The Conversation, 11 december.

Medlemsdiskussion