Om att lagstifta runt algoritmer

Idag vill jag tipsa om ett podd-avsnitt. Det är Ezra Klein som intervjuar Alondra Nelson. Hon var ansvarig för en 70-sidig rapport som Biden-administrationen släppte i oktober förra året med titeln “Blueprint for an A.I. Bill of Rights.”

Det är (ännu) inget styrande dokument utan som namnet antyder mer av ett utkast, eller förslag, som beskriver hur verktyg styrda av algoritmer behöver regleras.

Trots det självklara amerikanska utgångsläget så är konversationen mellan Klein och Nelson oerhört lärorik. Den berör många områden som är centrala för att förstå hur väsentliga riskerna med AI är. Och belyser samtidigt hur svårt det kan vara att komma åt vad som egentligen måste regleras och hur det ska ske.

Några punkter som kanske väcker din nyfikenhet:

- Utvecklingen inom AI och algoritmer jämförs i början av intervjun med kärnvapen, klimatkrisen och pandemin. Klein tvingar lite av en vändning på detta, med en blick på det som skapar nytta.

- Nelson bottnar i att det är när algoritmer har en interaktion med människor som vi måste få en tydligare policy på plats. När vi bland annat påverkar människors frihet, deras tillgång till tjänster och resurser och deras hälso- och sjukvård.

- Samtidigt som man får erkänna att algoritmer gör mycket nytta inom vissa områden (vetenskap, sjukvård) får det inte det lura oss att förbise vikten av att aktivt skydda människors fri- och rättigheter. Vi får inte låta algoritmerna "härja fritt".

- Blueprint for an A.I. Bill of Rights togs fram ur perspektivet att skapa bästa möjliga utfall för människor. Exempelvis: System ska vara säkra. Din information och din integritet ska vara skyddad. Algoritmer ska inte kunna användas för att diskriminera mot dig. De grundläggande principerna ska hålla även när tekniken utvecklas och förändras. Och man vill påminna om att en hel del lagar redan är relevanta för AI-reglering.

- En metod som beskrivs är red teaming. Det handlar om att de som utvecklar en tjänst sätter den i händerna på en annan grupp människor (ofta branschkollegor) som får i uppdrag att stresstesta tjänsten för att se hur och vad som kan gå fel med den. Mer än att stresstesta kan man säga att de aktivt försöker ha sönder den och göra elaka saker med den för att upptäcka alla sätt som tjänsten kan bidra till skada på. För att sedan ta de insikterna och försöka förbättra systemet. Den uppenbara svagheten i detta är ofta just att det är branschkollegor som gör jobbet, och utsatta människor är själva inte delaktiga.

- Rapporten i sin nuvarande form riktar sig till såväl lagstiftare som systemutvecklare och allmänhet – i ett försök att göra fenomenet mer förståeligt och handgripligt. Lättare att prata om. Det är en typ av ansats jag tror vi måste se mer av från ledare i både privat och offentlig sektor.

- Rapporten uttrycker “Du ska veta att ett automatiserat system används och hur och varför det bidrar till utfall som påverkar dig." Klein ifrågasätter detta och menar att inte ens tillverkarna av verktygen har koll på hur tjänsten kommer fram till alla sina svar. Och att det är lite av poängen (enligt många förespråkare av AI).

- Detta leder in i en diskussion om man kan skilja på avgränsade system och modeller som är tränade att vara generella och kunna användas till lite vad som helst. Om det är ett krav att svaren ska kunna vara förutsägbara så måste systemen byggas på helt andra sätt.

- Klein ger exemplet med screening av patienter för cancer. Om vi har krav på att systemen ska vara förståeliga för människor så kanske vi bromsar utvecklingen av dessa verktyg och under tiden dör människor. Sannolikt ett argument vi kommer höra allt oftare som kritik mot alltför stram reglering.

- Diskussion fortsätter men jag vill också bara nämna att de två även pratar om representation som en utmaning, att konsultera tillräckligt många människor och grupperingar för att säkerställa att man tagit hänsyn till och identifierat väsentliga risker. Det här är något av en käpphäst för mig och har man hört mig föreläsa om AI och mänskliga rättigheter så vet man att mycket av min kritik också bottnar i maktkoncentration och monokultur. Vi vet var verktygen byggs och vem som kommer få mest nytta av dem.

Låt mig gärna veta dina funderingar i ämnet kring reglering av dessa verktyg.

Läs eller lyssna på avsnittet

Du kan läsa en transkribering av avsnittet eller lyssna på det i din favorit-app.

Bonus 1: personlig samling poddtips direkt i din poddspelare

Ibland tipsar jag om podd-avsnitt men du kanske inte vill prenumerera på hela programmet, eller leta fram det. Då kan man i stället prenumerera på min lyssningslista. Genom att lägga till RSS-flödet för denna lista i sin podd-spelare så uppdateras man varje gång jag lägger till ett nytt avsnitt (från olika poddar) och kan lyssna direkt.

Bonus 2: Nio-minuters föreläsning på svenska om tillgänglighet och AI

Våren 2020 resonerade jag på detta sätt när jag blev inbjuden att prata om tillgänglighet och hur lagarna ska hänga med i den snabba tekniska utvecklingen med AI och robotisering. Jag tycker resonemanagen håller fortfarande. Håller du med?

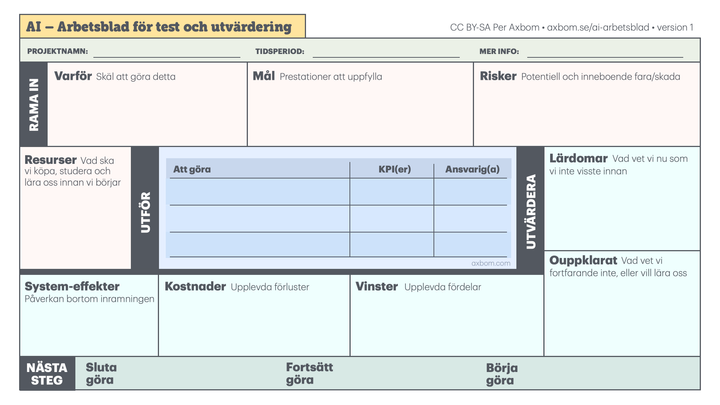

Kartlägger du påverkan och hanterar digital etik idag?

Kommentera