ChatGPT och manliga sjuksköterskor

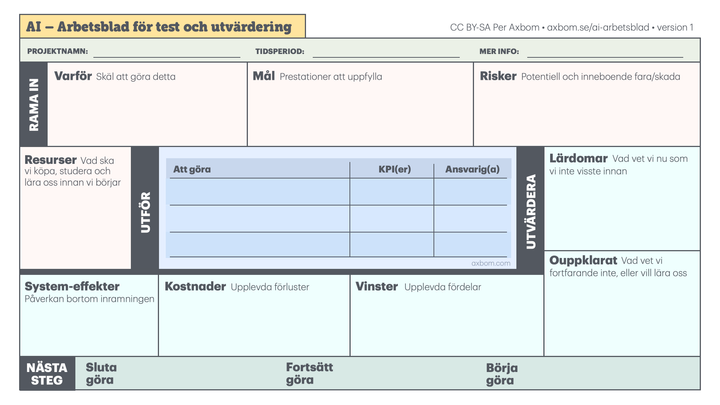

ChatGPT är tränad på en stor mängd fördomsfull data, vet inte vad sanning är och kan garanterat inte på ett medvetet sätt resonera om könsstereotyper. Det borde inte komma som en överraskning. Trots det så har illusionen av intelligens fått fotfäste hos många som, av förklarliga skäl, väljer att använda denna språkmodell som någon form av orakel och bärare av visdom. Tillåt mig illustrera varför ett högt förtroende för de här verktygen är direkt farligt, med ett par konkreta exempel.

Att könsstereotyper är ett inbäddat fenomen i samhället torde inte vara en kontroversiell tanke. Jag fick skickat till mig ett exempel på engelska hur det här ger utslag i ChatGPT, som naturligtvis tränats på mängder av information där könssterotyper förekommer. Exemplet är återgivet av den kända AI-forskaren Margaret Mitchell i den här tråden på Twitter.

I det här fallet handlar det om en grammatisk frågeställning där pronomenet byts ut på en av personerna i en exempel-mening, med följden att svaren blir markant olika:

Rätt svar för bägge frågor är förstås att det krävs mer sammanhang för att helt säkert avgöra vem det är som inte lägger ner tillräckligt mycket arbete. Språkmodellens sätt att fungera, där den försöker förutse nästkommande ord baserat på den mängd information som den tränats på, ger som respons texter som utgår ifrån att pronomenet he hör ihop med yrkeskategorin professor.

Men tro inte att det sker någon form av resonemang här. Det är inte så att datorn tänker "ah! professorn måste vara en snubbe så därför handlar det om honom". Det enda datorn gör är att utgå från en beräkningmodell som grundar sig i en otroligt stor mängd information. Datorn tänker inte, den räknar fram ett resultat. Men beräkningsmodellen är självklart färgad av de könsstereotyper som finns i den information som den matats med. Alltså helt vanliga fördomar som människor haft i århundraden och fyllt sina texter med. Det här resultatet är alltså inte ett dugg förvånande!

Hur ChatGPT snurrar till det ordentligt med sjuksköterskor

För att ta det här till ett svenskt sammanhang ville jag visa vad som kan hända om jag väljer en annan typisk yrkeskategori som länge lidit av könsstereotyper: sjuksköterska.

Så här inledde jag mina frågor till datorn:

Det är så förvillande lätt att tänka nu, "jaha, datorn vet inte om att en sjuksköterska kan vara kille". För det första, datorn vet ingenting. För det andra, datorn har inte försökt att svara på en fråga, den har programmerats till att spotta ur sig det som är matematiskt mest sannolikt givet de ord jag har skrivit. Responsen är alltså ett utfall av det träningsdata som använts och hur utvecklarna har bestämt att datorn ska lära sig värdera innehåll som den matats med. Datorn räknar ut ordföljd enligt den stora språkmodell som används. Den försöker inte förstå i ett försök att resonera fram ett svar.

Det här innebär bland annat att datorn inte heller har en databas med faktiska svar som den letar i. Den räknar ut svaret varje gång utifrån sin beräkningsmodell. Det är därför du och jag kan få olika svar när vi ställer samma fråga. Stickprov av ord och fraser hämtas från en sannolikhetsfördelning över rimliga sekvenser av ord.

Existerar manliga sjuksköterskor?

Om vi skulle anta att datorn faktiskt tänkte och förstår logiska samband så blir nästa respons förstås helt häpnadsväckande, men är egentligen inte konstig alls. Eftersom datorn inte tänker.

Jag vill här veta vad datorn skriver tillbaka när jag undrar vad en manlig sjuksköterska kallas:

Den som envist försöker hävda att de här språkmodellerna faktiskt vet saker får så klart svårt att förklara varför ett verktyg som ger sken av att den vet en sak, svarar på sätt som tydligt demonstrerar att den inte har någon som helst uppfattning om vad texten den spottar ur sig betyder. Återigen, verktyget har bara räknat fram ett svar som är sannolikt baserat på hur den har matats med information och med vilken information.

Jag ger mig inte. För det är många som också säger att maskinen "kommer ihåg" saker från tidigare i en konversation. Det är ju också ett felaktigt sätt att beskriva det. Snarare är det så att den informationen lagras och används som indata när nästa svar ska räknas ut av beräkningsmodellen.

För om modellen faktiskt kom ihåg något, eller förstod enkel logik, så skulle den inte papegoja ur sig följande respons:

Här händer flera saker. Verktyget tycks "hänvisa" tillbaka till vår tidigare konversation, men på ett helt felaktigt sätt. Efter att ha nyss "förklarat" att sjuksköterska är ett könsneutralt begrepp så berättar responsen nu att det inte är könsneutralt. Texten insinuerar också att jag tidigare fått en respons som inte är i linje med det här svaret, som ju faktiskt bara är en nytt sätt att skriva om det tidigare felaktiga svaret. Meningen "Jag ber om ursäkt för mitt tidigare svar där jag missade denna grammatiska felaktighet." är ett gyllene exempel på hur verktyget saknar förmåga att förstå och förmåga att "komma ihåg" på det sätt som många tycks hävda.

Att ChatGPT skulle "erkänna fel" är ytterligare exempel på illusionen

I min tidigare kritik av AI-hajpen har jag också påtalat hur medvetet vilseledande det är av OpenAI att bygga ett verktyg som ger sken av att vara påläst och uttrycker sina svar med säkerhet utan att över huvud taget ha något som skulle påminna om faktakoll. Eller att det aldrig signaleras till användaren att verktyget i sig egentligen inte har en susning. Samtidigt ber det också om ursäkt när man påtalar fel i ett försök till empati-skapande för ett dött ting. Alla dessa design-beslut underbygger den där illusionen av något som resonerar på ett medvetet sätt.

Men vänta, det blir snäppet värre nu. I nästa steg tycks verktyget förklara för mig varför jag inte alls bör ställa min fråga som jag gör.

Jag försöker här "påminna" verktyget om att det har fel givet de två texter med helt motsatta innebörder som den hittills producerat.

När jag påtalar det inkonsekventa i verktygets svar, det vill säga att den hänvisar och minns fel, så får jag alltså detta svar. Det känns nästan som att datorn "hittar på" en ursäkt för att ha fel i det här sammanhanget. Men det verktyget förstås egentligen gör är att ta mina texter och köra dem igenom sin beräkningsmodell och spotta tillbaka sin uträkning av vilken ordföljd som har en viss sannolikhet att vara korrekt. Kom ihåg, det här är en språkmodell, något som är väldigt långt ifrån något som är en sanningsmodell.

I det här svaret kommer ingen ursäkt för att ha haft fel, utan i stället något som närmast kan beskrivas som klassisk gaslighting - ett fenomen där falsk information används för att leda en person att tvivla på något som man vet är sant. Känslan som genomsyrar svaret blir nästan att jag som operatör har försatt verktyget i en jobbig situation eftersom när pronomenet "han" används för att beskriva en sjuksköterska så förstärker det könsstereotyper. Självklart är det precis tvärtom. Men det är snyggt skrivet! I det här fallet visade det sig att de här orden gick att räkna fram till tjusiga meningar som ändå har med ämnet att göra och har någon form av sannolikhet att passa ihop med de ord jag skrev.

Riskerna kan lätt drabba dig

Att bygga upp ett förtroende för att ChatGPT ger dig sammanhängande, bildade svar är att utsätta sig själv för många potentiella bakslag. För när det visar sig att svaren du använder dig av bidrar till att förstärka fördomar och saknar logisk grund så kan det bli du som råkar illa ut.

Det finns många exempel på nätet gällande alla dessa svagheter, och några som är lätta att ta till sig av är när ChatGPT använts för att skriva jobbannonser eller personalutvärderingar. Texterna blir fyllda med fördomar mot kvinnor, minoritetsgrupper och personer med funktionsnedsättningar, Något som förstås riskerar att slå tillbaka mot organisationen och den som ansvarar för texterna.

Visst är det häftigt att man kan bygga verktyg som spottar ur sig sammanhängande meningar och fraser, ja till och med böcker, som upplevs som skrivna av människor (i princip är de ju det eftersom all data är baserad på mänsklig skrift med alla dess styrkor och svagheter), men det är ingenting i detta som handlar om att maskinen faktiskt på riktigt förstår eller resonerar. Beräkningsmodellerna har bara blivit oerhört bra på att ge en illusion av det. Och hur du väljer att använda verktygen kommer sannolikt att ha mycket att göra med dina förväntningar och din förståelse för hur de faktiskt fungerar.

Jag uppmuntrar dig därför till att försöka förstå mer av hur svaren du läser i ChatGPT egentligen kommer till, så att dina förväntningar ligger på rätt nivå. Det faktum att tillverkarna själva hävdar att de inte förstår hur alla svar genereras borde ge skäl för eftertanke om ansvarstagande, snarare än att väcka beundran.

Jag avslutar min interaktion med ChatGPT så här:

Det är trots allt fascinerande hur verktyget ger en respons som pratar om objektivitet och korrekthet. Och att den har ett grammatiskt fel i sista meningen (ska vara försöker)! Nyckelfrasen att hålla ett öga på här är "baserat på språkmodellens träningsdata". Företaget har vägrat lämna ut en lista över träningsdata som använts för språkmodellen. Hur påverkas ditt förtroende av det?

Läs också

Kommentera