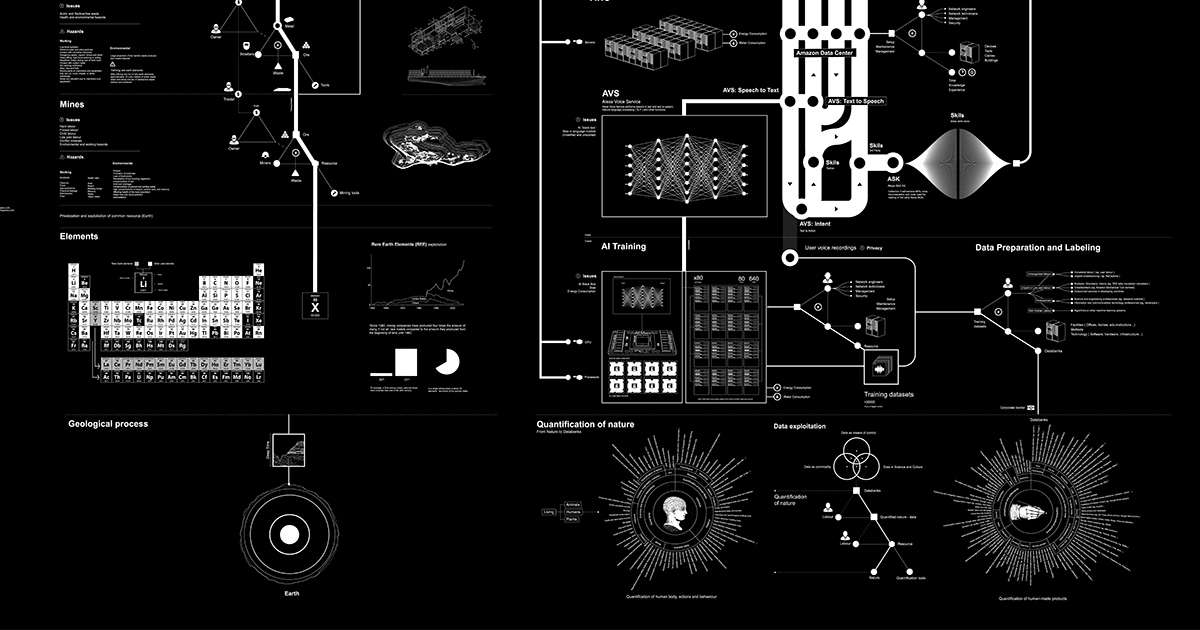

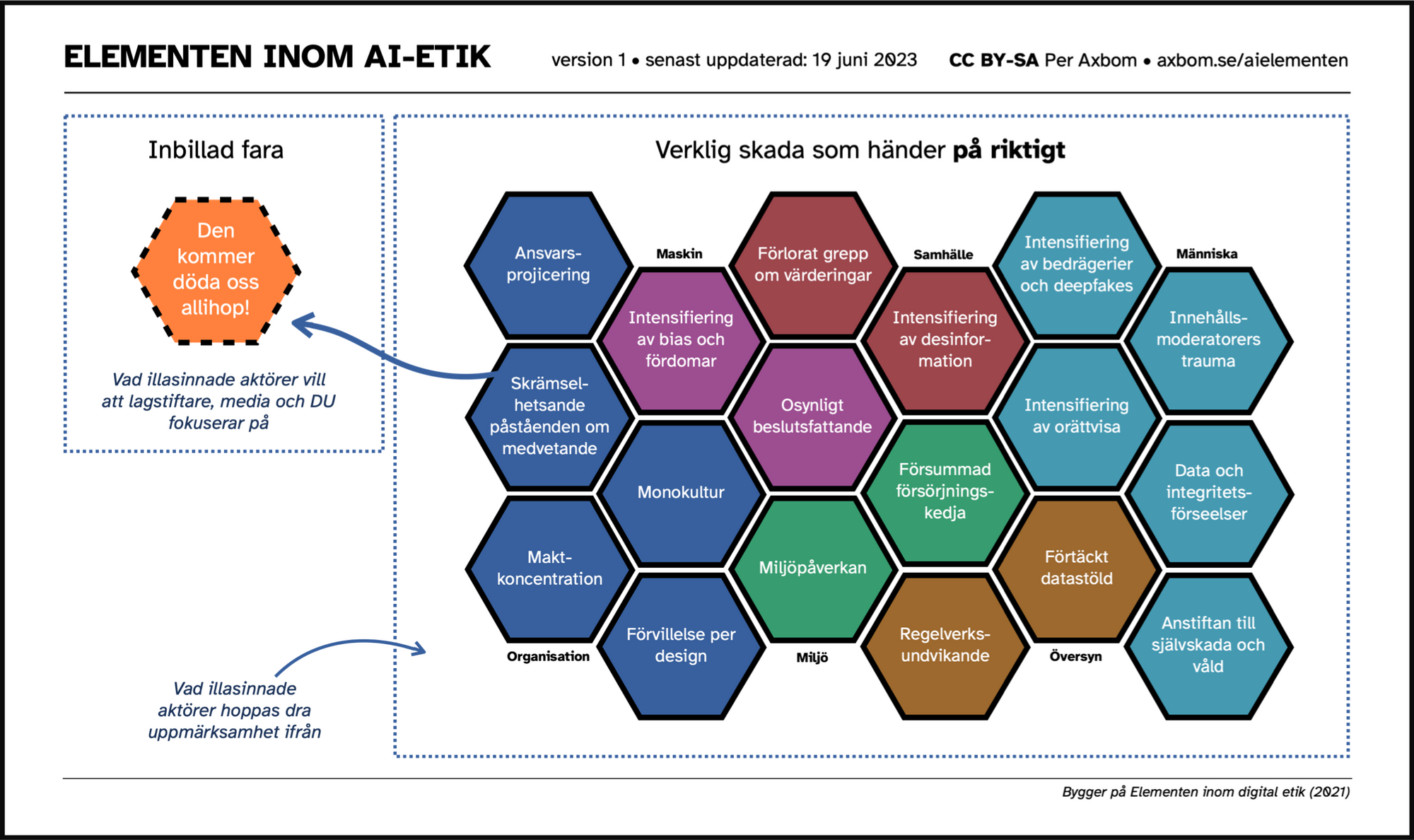

Teknikens skadliga effekter kan hanteras och mildras. Men inte om vi inte pratar om dem. Inte heller om vi låter oss luras att fokusera på vilseledande berättelser. I diagrammet Elementen inom AI-etik kartlägger jag skador som det rapporterats om, som har pågått länge och varav många förutspåtts innan de ägt rum. Som ett verktyg kan det ge vägledning och diskussionspunkter för att förstå hur du kan prioritera ditt arbete med "smarta" verktyg, och uppmärksamma att alla team som distribuerar eller använder AI behöver en strategi för att begränsa många olika typer av skador.

Det här diagrammet bygger på Elementen inom Digital Etik (2001). Skadorna i det ursprungliga diagrammet är alla fortfarande relevanta, och vad det här diagrammet gör är att ge en fokuserad översikt över de typer av skador vi ser en ökning av med den pågående utvecklingen av AI inom olika branscher – och då särskilt generella och generativa verktyg. Hämta gärna inspiration hos det ursprungliga diagrammet för att få idéer om hur ett verktyg som detta kan användas i utbildning och projektarbete.

Följande är korta sammanfattningar av varje element för att ge dig en bättre förståelse för vad de refererar till. Jag håller på att sätta ihop en workshop där man lär sig begränsa den typ av skador som elementen beskriver, och jag föreläser regelbundet om digital etik, vilket självklart berör AI. Om det är något som skulle intressera dig och din organisation, hör av dig.

Ladda ner

Elementen – korta sammanfattningar

Det finns sex övergripande sektioner (Organisation, Maskin, Samhälle, Människa, Översyn och Miljö), och totalt 18 element i diagrammet.

Organisation

Dessa element gäller egenskaper och intressen hos organisationer som utvecklar AI-drivna tjänster och produkter inom såväl privat som offentlig sektor.

Ansvarsprojicering

Jag är förtjust i termen "Moral outsourcing" som myntats av Dr Rumman Chowdhury. Det relaterar till hur tillverkare av AI lyckas skjuta över moraliskt beslutsfattande till maskiner, som om de själva inte har något att säga till om.

Genom användning ordet ansvar vill jag betona att organisationer har en tendens att inte bara undandra sig moraliska överväganden utan också det konkreta ansvar som måste åtfölja tillverkningen av produkter och tjänster. Projicering är lånat från psykologin och åsyftar hur tillverkare, och de som implementerar AI, vill bli rentvådda och projicerar sin egna svagheter på något annat – i det här fallet själva verktyget.

Inramningen av AI tycks ge tillverkare och produktägare ett "Slipp-ur-fängelse kort" genom att skylla på den maskin de har skapat, som om de inte har någon kontroll över vad de gör. Föreställ dig att du köper en tvättmaskin som krymper alla dina kläder, och att tillverkaren kan undvika allt ansvar genom att hävda att tvättmaskinen har ett "eget sinne".

Maskiner är inte oetiska, men tillverkarna av maskiner kan agera oetiskt.

Monokultur

Idag finns det nästan 7 000 språk och dialekter i världen. Endast 7 procent återspeglas i publicerat onlinematerial. 98 procent av internets webbsidor publiceras på bara 12 språk, och mer än hälften av dem är på engelska. Även om en maskin skulle matas med innehåll från hela Internet är det fortfarande en liten del av mänskligheten.

76 procent av cyberbefolkningen bor i Afrika, Asien, Mellanöstern, Latinamerika och Karibien, medan det mesta av onlineinnehållet kommer från andra håll. Ta till exempel Wikipedia, där mer än 80 procent av artiklarna kommer från Europa och Nordamerika.

Fundera nu på vilket innehåll de flesta AI-verktyg tränas på.

Här är vad jag ursprungligen skrev om detta element:

Genom linsen av en liten del av mänsklig erfarenhet och omständigheter är det svårt att föreställa sig och förutse vidden av alla de perspektiv och öden som en ny skapelse kan påverka. Homogeniteten hos de som har antagit förmågan att bygga och skapa i det digitala rummet innebär att det främst är deras spegelbilder som gynnas – med bristande tanke på välbefinnande hos de som inte är synliga i den reflektionen.

Förvillelse per design

Många AI-verktyg är medvetet byggda för att ge illusionen av att prata med något som tänker, reflekterar eller till och med är ångerfullt. Dessa designbeslut föder det farliga tankesättet att betrakta verktygen som kännande, levande varelser. Som nämnts tillåter detta tillverkare att undvika ansvar, men det bidrar också till komplexa förtroende- och relationsfrågor som människor tidigare bara haft med faktiskt kännande varelser. Vi vet väldigt lite om vad det gör med människors känsloliv och välbefinnande på lång sikt att regelbundet interagera med något som är designat för att ge sken av att ha mänskliga känslor när det faktiskt inte har det.

Det finns många skäl att anta att människor kan bygga starka band till verktyg som producerar oförutsägbart innehåll som känns personligt. Och antalet människor som behöver professionell hjälp för att hantera sin psykiska hälsa – och istället vänder sig till chatbottar styrda av AI – växer förstås snabbt. Ibland uppmuntras de till och med att göra det.

Maktkoncentration

När makt finns hos några få kommer deras egna behov och bekymmer på ett naturligt sätt placeras i första rummet och prioriteras. Ju mer deras behov prioriteras, desto mer makt får de och deras gelikar. Vem är med på dina möten? Vem saknas? Tre miljoner AI-ingenjörer är 0,0004 % av världens befolkning.

Skrämselhetsande påståenden om medvetande

Det kommer ett ökande antal rapporter som beskriver en framtid, närmare varje dag, där en AI tar över världen och gör människor föråldrade och till en förbrukningsvara. Det drivs inte sällan av stora namn i branschen. Genom att använda överdrivna rykten om överhängande fara lyckas de hålla människors och medias uppmärksamhet och i hög grad kontrollera vilka berättelser som får spridning.

Påståendena resulterar i att:

- Styra uppmärksamheten bort från verkliga skador som faktiskt äger rum

- Öka förtroendet för giltigheten av maskinernas utdata eftersom de framställs som "allmäktiga varelser"

- Stödja idén om ansvarsprojicering (från människa till maskin)

- Ge mer makt till domedagsprofeterna eftersom de är de enda som kan rädda oss, och därmed också de som kan tala om för lagstiftare hur de ska reglera tekniken

Inbillad fara

I diagrammet har jag valt att göra denna sista punkt tydlig genom att visa hur elementet "Den kommer döda oss allihop!" är en inbillad fara utan trovärdig uppbackning. Det är en skada i sig att driva den berättelsen.

Maskin

Allt eftersom mer och mer beslutsfattande automatiseras måste fler människor vika sig för algoritmer, maskininlärning och fördunklade förmågor och funktioner. Dessa maskinelement beskriver de inneboende egenskaperna hos maskiner som förvärrar potentiell skada.

Intensifiering av bias och fördomar

En inneboende egenskap hos AI är dess förmåga att fungera som en accelerator för andra skador. Genom att tränas på stora mängder data (ofta utan tillsyn) som oundvikligen innehåller fördomar, övergivna värderingar och trångsynta kommentarer så kan dessa svagheter komma att reproduceras och förstärkas i utdata. Det är troligt att detta även kommer hända obemärkt (särskilt när det inte övervakas aktivt) eftersom många fördomar är subtila och inbäddade i vardagligt språk. Våra egna föreställningar och tankefel, så kallade bias, kan göra dem svåra att uppfatta. Och vid andra tillfällen kommer det att ske ganska tydligt, med botar som häver ur sig inskränkt, kvinnofientligt och rasistiskt innehåll.

Osynligt beslutsfattande

Ju mer komplexa algoritmerna blir, desto svårare är de att förstå. I takt med att fler är inblandade, tiden går, integrationer med andra system görs och dokumentationen är felaktig, desto längre undgår de mänsklig förståelse. Många företag kommer att dölja egen kod och undvika granskning, och ibland själva förlora hela bilden av hur koden fungerar. Man kommer inte kunna förklara hur eller varför vissa beslut tas. Att avkoda och förstå hur beslut fattas kommer därmed att vara öppet för oändligt färre personer.

Och det stannar inte där. Detta påverkar också människors autonomi. Genom att dölja beslutsprocesser (hur, när, varför beslut fattas, vilka alternativ som finns tillgängliga och vilka personuppgifter som delas) är det allt svårare för individer att göra väl underbyggda val för sitt eget bästa.

Samhälle

Den digitala gryningen har återverkningar för samhället i stort, med inflytande på värderingar, möjligheter, rädslor och trygghet för att nämna blott några. Det som inte tidigare var möjligt är nu i medvetet fokus och uttrycks ofta i frälsar-liknande budord utlovade av digital transformation (idag ofta AI). Nyvunna förmågor och ansträngningar att registrera och mäta precis allt i siffror stjäl uppmärksamheten från spiritualitet, omtanke och sensorisk sensitivitet.

Förlorat grepp om värderingar

Effektivitet som innebär att lämna över vissa uppgifter till maskiner innebär med nödvändighet att vi ger upp något. Vi frigör något. Även om det ofta hävdas att vi ger upp det vardagliga och tråkiga för att leva mer lyckliga och berikade liv är detta inte alltid fallet. Vi måste hålla ett öga på vad vi förlorar när vi vinner något annat. Genom att skjuta över beslutsfattande till maskiner (som byggts av någon annan och tränats på en obskyr mängd innehåll) uppmuntras många människor att ge upp ansträngningar som kan ha varit viktigare än själva besluten, t.ex. spekulation, resonerande och grubblande. Det vi värdesätter förändras och det är inte alltid tydligt att vi också lämnar över värdegrunden för vårt beslutsfattande till en extern part.

Om samhälleliga värderingar förändras över tid, hur kommer de att förändras när de väl är en del av maskinens inre arbete?

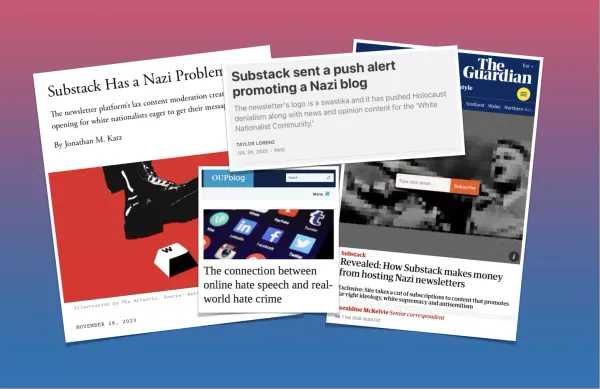

Intensifiering av desinformation

Den skada som nästan alla verkar vara överens om är det överflöd av desinformation som många av dessa verktyg kommer att tillåta nästan utan kostnad för illasinnade aktörer. Det händer förstås redan. Det finns både den typ av desinformation som trollfabriker nu med glädje kan generera i mängder med perfekt grammatik på många språk, och även den typ av desinformation som sprider sig med den dagliga användningen av dessa verktyg, och ofta omedvetet.

Den senare typen av desinformation genereras och sprids även av högutbildade och yrkesverksamma inom respekterade offentliga verksamheter. Verktygen är redan så förvillande bra på att framstå som självsäkra när de uttrycker nonsens i ett trovärdigt, blomstrande och förföriskt språk.

En oro som nu dyker upp och som fortfarande söker svar är vad som kommer att hända när verktygen börjar "tränas" med de texter som de själva har genererat.

Människa

I stort sett alla aspekter av AI-etik relaterar till negativ påverkan på människor, men några element kommer utmärkande nära inpå och är mer direkta och påtagliga i hur de drabbar personligt välbefinnande.

Intensifiering av bedrägerier och deepfakes

Verktyg som genererar trovärdigt innehåll med övertygande formuleringar, eller verktyg som kan imitera din röst eller till och med ditt utseende, öppnar upp spelplanen för bedrägliga aktiviteter som kan vara skadliga för psyke, ekonomi, rykte och relationer. Människor kan fås att tro saker om andra som helt enkelt inte är sanna, eller till och med falla offer för illusionen att en familjemedlem pratar med dem i telefon även när det är en främmande person.

Intensifiering av orättvisa

På grund av systemproblem och det faktum att fördomar blir inbäddade i dessa verktyg, kommer dessa fördomar att få kännbara konsekvenser för människor som redan saknar makt. Poängsystem används ofta av automatiserade beslutsfattande verktyg och dessa poäng kan till exempel påverka jobbmöjligheter, välfärd/bostadsbehörighet och rättsliga utfall.

Innehållsmoderatorers trauma

För att vi ska undvika att se traumatiserande innehåll när vi använder många av dessa verktyg (som fysiskt våld, självskada, barnmisshandel, mord och tortyr) måste detta innehåll filtreras bort. För att det ska filtreras bort måste någon titta på det. De arbetare som utför denna filtrering exploateras ofta och lider av posttraumatiskt stressyndrom utan adekvat vård för att hantera sitt lidande. Många av dem har ingen aning om vad de ger sig in på när de tar jobbet.

Data och integritetsförseelser

Det finns flera sätt för personlig data att ta sig in i AI-verktygen. För det första, eftersom verktygen ofta tränas på data tillgänglig online och på ett oövervakat sätt, kommer personuppgifter ta sig in i verktygen när de utvecklas. Data kan oavsiktligt ha publicerats online eller kan ha publicerats för ett specifikt syfte. Och då sällan ett syfte som innebär matning av ett AI-system och dess uppsjö av utdata. För det andra, personliga uppgifter matas in i verktygen av vanliga användare genom vårdslös eller hänsynslös användning – data som ibland också lagras och används av verktygen. För det tredje, när många datapunkter från många olika källor länkas samman i ett verktyg kan de avslöja detaljer om en individs liv som någon enskild information eller datapunkt – till synes harmlös – inte kan.

Anstiftan till självskada och våld

Det har förekommit flera vittnesrapporter om AI-chatbotar som uppmuntrar eller sympatiserar med en mänsklig operatörs övergrepp mot sig själva eller andra. Kommer tillverkarna att kunna ge en garanti för att detta helt undviks i framtiden? Och om inte, vilka andra begränsande faktorer måste tillföras verktygen?

Översyn

Det här avsnittet handlar om det svåra med att övervaka, reglera och hantera potentiell negativ påverkan relaterad till AI.

Förtäckt datastöld

För att bli så "bra" som de är i sin nuvarande form har många generativa AI-system tränats på enorma mängder data som inte var avsedda för detta ändamål och vars ägare och skapare inte har efterfrågats samtycke. Bara publiceringen av en artikel eller bild på webben innebär inte att den kan användas av vem som helst till vad som helst. Verktyg för generativ AI tycks komma undan med att ignorera upphovsrätt.

Samtidigt finns det många krångligheter som lagstiftare och beslutsfattare måste förstå för att kunna resonera på ett bra sätt kring intrång i rättigheter eller privilegier. Bilder är till exempel inte duplicerade och lagrade, de används för att mata en beräkningsmodell, vilket är ett argument som ofta används av försvarare för att förklara hur generativ AI bara "inspireras" av andras verk och inte "kopierar". Det finns flera pågående rättsfall som ifrågasätter denna uppfattning.

Strålande genomgång av hur generativ AI stjäl innehåll, och hur verktygen faktiskt också lagrar innehåll.

Regelverks-undvikande

AI kan betraktas som ett undvikande av regler bara genom den stora mängden översteg som görs då verktygen driftsätts och används på marknaden. En möjlighet är att missbruk av andras innehåll kan behöva normaliseras eftersom tillsyn är ouppnåelig, om inte fler begränsningar snabbt kommer på plats avseende "datastöld", distribution och användning. Det faktum att så många av dessa företag kan släppa verktyg baserade på andras verk, utan att behöva avslöja vilka dessa verk är, kan bara ses som ett moraliskt dilemma av stora proportioner. Dessutom: vilka personuppgifter som är inbäddade och kan komma att missbrukas eller missbrukas är inte bara okänt för användarna av verktygen, utan är i stor utsträckning okänt även för tillverkarna av verktygen.

Det faktum att nationer har olika lagar medför nya hinder för implementering över gränserna. OpenAI:s vd Sam Altman uttryckte till exempel att han skulle dra sig ur EU om han måste följa föreslagen lagstiftning. [uppdatering: Två dagar senare backade han från dessa hot.]

Miljö

Elementen i detta avsnitt hänvisar till problem som skapas och/eller förbises under utvecklingen av digitala verktyg. De ignoreras ofta eftersom de anses vara sekundära villkor och inte direkt relaterar till syftet med det som skapas. Ibland ses de som oåtkomliga eller oundvikliga, men dessa faktorer måste fortfarande åtgärdas eller hanteras för att mildra negativa effekter.

Försummad försörjningskedja

För att realisera digitala tjänster och lösningar behöver vi hårdvara och mjukvara. Bakom produktionen av dessa kan det finnas en lång kedja av förtryckande relationer och exploatering av arbetskraft. Ett exempel är det stora behovet av kobolt, som används i litium-batterier, som ofta utvinns under orättvisa förhållanden i grymma miljöer påminnande om slaveri (inte sällan är det slaveri). Att inte överväga vilken roll man själv har, och vill ha, i försörjningskedjan som krävs för att lansera digitala tjänster är att ignorera ansvaret för den potentiella skada man åsamkar andra.

Miljöpåverkan

Energin som krävs för att hämta data, träna modellerna, driva modellerna och beräkna all interaktion med dessa verktyg är betydande. Även om exakta siffror ofta hålls hemliga, har det gjorts många studier om den stora miljökostnaden för att utveckla AI och åtgärder som måste vidtas. Med detta i åtanke är det lämpligt att ställa sig frågan om precis varje utmaning verkligen letar efter en AI-lösning. Kanske kan vi komma att se frasen "AI-drivet system" i samma ljus som "dieseldriven SUV".

Den hoppfulla delen

Anledningen till att jag vill bidra till förståelsen för de typer av skador som växer hand-i-hand med tillväxten av AI är för att alla skador är under mänsklig kontroll. Det gör att vi kan prata om dem i relevanta sammanhang. Vi kan arbeta för att undvika eller minimera dessa skador. Och vi måste kräva insyn från tillverkarna kring varje fråga. I stället för att låtsas som att ny teknik alltid är välvillig eftersom den kommer att "förbättra liv" (definitivt vissa liv mer än andra), är det en bra sak att lyfta dessa konversationer.

Om du har nytta av mina observationer så uppskattar jag alltid när du kan hjälpa mig genom att dela mina inlägg och verktyg i dina egna nätverk. Och jag är alltid nyfiken på att höra om dina egna tankar, perspektiv och erfarenheter. 😊

Mer referenser och vidare läsning

- Fast Company: Researcher Meredith Whittaker says AI’s biggest risk isn’t ‘consciousness’—it’s the corporations that control them

- DAIR Institute: Statement from the listed authors of Stochastic Parrots on the “AI pause” letter

- On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜

- Situating Search

Medlemsdiskussion