Varför det öppna brevet som vill pausa AI-utveckling är problematiskt

Tillämpad etik är inte en checklista. Det handlar om att lägga tid och kraft på att förstå riskerna för välbefinnande – med en uttalad ansats att undvika, minska och övervaka skada. Det låter då rimligt att anta att ett upprop för att pausa AI-utveckling är något bra. Kanske, ja… men nej.

Låt oss prata om några saker som berör det hyllade öppna brevet som undertecknats av personer som Elon Musk, Steve Wozniak, Yuval Noah Harari, Andrew Yang, Gary Marcus och Tristan Harris. Mer än ett öppet brev är det på många sätt ett vilseledande brev. Och vem har egentligen skrivit brevet?

Jag har själv kritiserat den pågående hajpen och det är nog lätt att förmoda att jag skulle hylla ett initiativ att "omedelbart pausa i minst 6 månader tränandet av AI-system mer kraftfulla än GPT-4".

Innan jag börjar lista varför jag inte hyllar detta brev, så vill jag lyfta in några koncept från elementen inom digital etik. Det finns många av de 32 elementen som är relevanta här, men de här tre täcker in många av aspekterna:

- Monokultur. Homogeniteten hos de som har antagit förmågan att bygga och skapa i det digitala rummet innebär att det främst är deras spegelbilder som gynnas – med bristande tanke på välbefinnande hos de som inte är synliga i den reflektionen.

- Maktkoncentration. När makt finns hos några få kommer deras egna behov och bekymmer på ett naturligt sätt placeras i första rummet och prioriteras. Ju mer deras behov prioriteras, desto mer makt får de och deras gelikar.

- Ethicswashing. Etiska koder, dedikerade råd, whitepapers, utmärkelser och liknande fenomen kan skapas för att ge sken av godhjärtade överväganden utan någon verklig substans under ytan.

Det öppna brevet i sig skulle kunna ses som ett potentiellt exempel på ethicswashing. Tanken är att genom att påstå sig visa omtanke om mänskligt välbefinnande så är jobbet med etiskt övervägande avklarat. Tillräckligt många människor runt om i världen kan införliva tanken att dessa mäktiga individer gör vad de kan för att stoppa farorna som AI utgör. Om de misslyckas kan det övergripande budskapet vara att "de har åtminstone agerat med goda avsikter". Det är ett snyggt salongstrick som kan ge många mäktiga aktörer en möjlighet att avsäga sig ansvar.

"Vi försökte. Vi har dokumentationen. Kolla på det här brevet."

Det visar inte heller på något som helst uttalat intresse för att lyssna på fler röster. Så det finns inget sätt att bekräfta någon ansträngning utöver själva undertecknandet av brevet.

Det mest uppenbara sättet att mäta brevets framgång skulle vara om en 6-månaders paus faktiskt respekteras för AI-utveckling som överskrider GPT-4:s kapacitet. Även om det fortfarande är höljt i dunkel hur detta faktiskt skulle hjälpa någon. Det är också oklart vem som skulle verifiera om ett system som är kraftfullare än GPT-4 arbetas på under den aviserade tidsramen, och hur.

Varför brevet bör vara grund för olust

Jag inser att jag redan påbörjat min argumentation men det finns några fler skäl till att jag tror vidare skepsism och ifrågasättande av brevet är på sin plats:

Värdorganisationen

Det är märkligt hur det i tider där det dagligen pratas om källkritik har gått förlorat för många journalister exakt var det öppna brevet har sin hemvist och vad denna organisation står för. Future of Life Institute är en av flera organisationer i ett nätverk av miljardärsdrivna teknokratgemenskaper som skyddar och främjar en filosofi som kallas longtermism, med sina rötter i en rörelse känd som effektiv altruism.

Du kanske har hört talas om longtermism och idén om att ombesörja att det vi bygger idag skyddar framtida människors intressen – alltså människor väldigt långt in i framtiden, tänk tusentals år. Men du kanske har missat hur företrädare för denna filosofi har visat sig prioritera människoliv långt in i framtiden framför nuvarande liv ("de är fler i antal"), argumenterat för att liv i rika länder är viktigare att rädda än liv i fattiga länder ( "de bidrar mer"), och påstått att klimatförändringarna kan tonas ner eftersom de inte är ett existentiellt hot ("åtminstone inte för hela mänskligheten").

Som Rebecca Ackerman skriver (min översättning):

Idéerna från effektiv altruism har länge mött kritik från domänerna filosofi och filantropi då de återspeglar vit västerländsk frälsare och undviker strukturella problem till förmån för abstrakt matematik. Iinte helt oförutsägbart är det många av samma invändningar som riktas mot teknikindustrin som helhet.

Förståelsen av denna filosofi ger sammanhang till några av de efterföljande poängerna. Tips om vidare läsning finns längst ner på sidan.

Stickspår: Det var lite bisarrt att se så många människor fråga efter bekräftelse på att Max Tegmark faktiskt skrivit under brevet, när han själv är president för institutet som ligger bakom brevet! Elon Musk är också listad som extern rådgivare. Det finns fortfarande en del att önska när det gäller grundläggande faktakoll.

I princip inget omnämnande av aktuella och bekräftade risker

Det är inte så att det inte redan sker skada på grund av dessa typer av verktyg. Varför skulle ett öppet brev som hävdar att man bryr sig om mänskligt välbefinnande inte uppmärksamma eller beskriva den skada som redan äger rum idag på grund av AI – och borde stoppas nu? Det är en självklar möjlighet att öka medvetenheten.

Jag pratar till exempel om:

- Säkerhetsfrågor runt integritet och olaglig åtkomst, som redan hänt.

- Det faktum att dessa verktyg tränats på stora mängder fördomsfull data och ofta vidmakthåller dessa fördomar.

- Det faktum att arbetare i Kenya, och på andra platser, utnyttjas för att träna dessa verktyg och måste genomlida skada för att avlägsna skadligt innehåll. En metod som länge använts av sociala medieföretag.

- En ökad insamling av biometriskt härledd data som allvarligt påverkar människans fria vilja eftersom det möjliggör utbredd personlig manipulation (deepfake med mera) och ger auktoritära regimer mer makt att undertrycka oliktänkande. Eller uppmuntrar demokratier att röra sig mot auktoritärism, när de med svagast röster blir överkörda.

- Klimatrisker givet stor energiåtgång när stora neurala nätverk tränas. Det är relevant att påpeka att de som gynnas mest av AI är de rika, medan de som lider mest av klimatkrisen är de fattiga. Den senare gruppen ser inte ut att få så mycket att säga till om när det gäller vad en 6-månaders paus skulle betyda för dem.

- Personer med ondskefulla avsikter får kraftigt förstärkta möjligheter att göra skada med malware och bedrägerier, men också att uppfinna kemiska vapen.

- Hur verktygen redan kullkastar konst, litteratur och utbildning (inklusive ägande av all data som verktygen tränas på) utan möjlighet att ta itu med dessa frågor på ett systematiskt och ansvarsfullt sätt.

- Utestängning av en stor del av den globala befolkningen helt enkelt på grund av det begränsade antalet språk som dessa verktyg tränas på.

- Dåligt underbyggda påståenden om ett datoriserat medvetande som leder till ogrundade rädslor (en skada som själva brevet bidrar till).

I brevet står uttryckligen att vidareutveckling av verktyg som är kraftfullare än GPT-4 bör pausas i sex månader. Som om skada bara är det som händer bortom detta. Jag skulle hävda att tiden är bättre använd till att ta itu med den skada som redan sker.

Fokus i brevet är mer förståeligt när man vet att "en mänsklighets-förstörande AI-revolt" är det som uttryckligen är av större intresse för teknokraterna inom longtermist-rörelsen. Inte det som sker här och nu.

Säljer idén om digitalt medvetande

Brevet gör ett imponerande jobb med att skrämma upp läsaren i fråga om en stundande intelligens som kommer att "överträffa oss i antal, överlista, kassera och ersätta oss". Deras största oro uttrycks som en "förlust av kontroll över vår civilisation".

Det kan mycket väl vara så att författarna till detta brev verkligen är rädda, då de plötsligt får känslan av att skadas av AI på samma sätt som miljontals andra människor redan skadas av AI.

Detta skulle förklara varför brevet inte fördjupar sig i de nuvarande skadorna och riskerna orsakade av AI. Dessa skador gäller helt enkelt inte brevets författare. Den implicita rädslan är att författarna själva nu skulle kunna påverkas negativt. Något som är okänt för dem.

Från brevet (min översättning):

Det här betyder inte en paus i den generella AI-utvecklingen, bara ett steg tillbaka från den farliga tävlingen mot allt större oförutsägbara "svarta lådor"-modeller med framväxande förmågor.

Det är nästa version av AI som oroar författarna, inte den som redan skadar andra.

Vilseledande citat

Det allra första referensen i brevet är till den i branschen ökända forskningsrapporten Stochastic Parrots. Men författarna till brevet framställer studien helt felaktigt. Så här skriver en av studiens forskare själv, Dr. Timnit Gebru från DAIR Institute (min översättning):

Den första referensen i det här dumma brevet är till vår rapport #StochasticParrots: "AI-system med människo-konkurrerande intelligens can utgöra djupgående risker till samhälle och mänsklighet, som visats av gedigen forskning[1]."

MEN

En av de primära slutsatserna i vår rapport är att en av de största farorna för stora språkmodeller är när man HÄVDAR att LLM har "människo-konkurrerande intelligens." De säger i princip raka motsatsen av vad vi säger, och refererar till vår forskning?

Du kan vilja läsa det där igen. Det öppna brevet, som säljer idéen om ett digitalt medvetande, använder som sin första referens en rapport som förklarar att dessa anspråk på på medvetande är en av de starkaste bidragande faktorerna till skada. Alltså, vi skulle ha kunnat sluta där.

Som professor Emily M. Bender, även hon medförfattare till Stochastic Parrots, påpekar i sina egna kommentarer till brevet, finns det ytterligare frågor när det kommer till hur väl referenserna stödjer brevets argument.

Valet av "6 månader"

Man måste ändå undra lite över den föreslagna tidsramen i brevet:

vi åberopar alla AI-laboratorier att genast pausa, i minst 6 månader, tränande av AI-system mer kraftfulla än GPT-4

Alla som någon gång arbetat inom IT vet att 6 månader sällan är tillräckligt lång tid att vända på en utveckling, och så klart inte tillräckligt lång tid för att vända premisserna för skada orsakad av AI. Varför väljs denna tidslängd som baslinjen? Vad kan realistiskt sett åtgärdas på 6 månader? Ett halvår kanske låter som lång tid i vissa sammanhang men i det här sammanhanget är det en blinkning. Det känns verkligen som ett villospår.

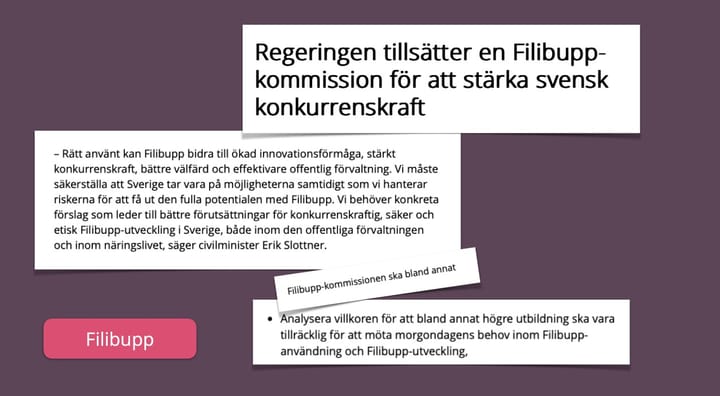

När brevet föreslår att "regeringar borde träda in och införa ett moratorium" om författarnas uttalade regel på sex månader inte följs är det inte klart vilka regeringar det handlar om som bör följa deras instruktioner. Men vi vet verkligen att få länder har något att säga till om i denna utveckling, även om effekterna av dessa verktyg redan är betydande för de flesta.

En ytterligare varningssignal är att ett verkligt intresse av att hjälpa människor inte skulle fokusera på att utarbeta en fördefinierad premiss likt den som beskrivs i det öppna brevet. Författarna har redan bestämt de exakta reglerna för vad som behövs (6 månaders paus eller regeringars verksamhetsstopp). Det finns inget erkännande av att fler perspektiv än det som författarna företräder skulle vara av värde.

Etiken kräver att vi involverar människor som skadas. Den som menar allvar med etik skulle betona vikten av att involvera människor som är i riskzonen och som redan lider av konsekvenser. Den som menar allvar med etik skulle inte göra tidiga antaganden om hur inkluderingen av röster ska ske.

Men här är vi nu... tydligen är svaret 6 månader av paus i utvecklingen, av en specifik typ av AI som inte har släppts ännu.

Vi kontra dom

Det är mycket Vi-referenser när man pratar om AI. Men det är tydligt att de som bygger AI är ett litet antal Dom. Det är inte ett Vi. Frågan är hur mycket makt Dom ska tillåtas att utöva över resten av världen.

Och från brevet (min översättning och fetstil):

Mänskligheten kan njuta av en blomstrande framtid med AI. Efter att ha lyckats skapa kraftfulla AI-system kan vi nu njuta av en "AI-sommar" där vi skördar frukterna, konstruerar dessa system till klar nytta för alla och ger samhället en chans att anpassa sig

Jag undrar om alla människor som redan lider av fördomar befästa i dessa verktyg kommer att identifiera sig som en del av detta Vi, och njuta av skönheten i denna "AI-sommar", redo att anpassa sig. Jag skulle anta att många redan tvingas anpassa sig från stund-till-stund, snarare än att åtnjuta mer självständighet. Samtidigt som de ser andra skörda frukterna.

Sättet som detta brev ignorerar pågående skada, och insinuerar digitalt medvetande, säger mycket om dess avsikt.

Referenser

Förespråkare för ansvarsfull innovation som ogillar brevet

Om longtermism

En kurerad lista med podd-avsnitt

Fler källor till artikeln

/cdn.vox-cdn.com/uploads/chorus_asset/file/23324138/1939292.jpg)

Ett annat av Sam Altmans företag

På svenska

Kommentera